Deep Learning

زمان تخمینی مطالعه: 15دقیقه

یادگیری عمیق (Deep Learning) یک شاخه از یادگیری ماشین است که بر پایه ساختار شبکههای عصبی مصنوعی (Artificial Neural Networks) استوار است. این روش، مدلسازی قدرتمندی را برای تشخیص الگوها و استخراج ویژگیهای پیچیده از دادهها فراهم میکند. نام “عمیق” به این دلیل استفاده میشود که شبکههای عصبی عمیق، معمولا شامل چندین لایه پنهان (Hidden Layer) هستند که به طور تدریجی ویژگیها را از ورودی استخراج میکنند.

با استفاده از یادگیری عمیق، میتوان انواع مسایلی که روشهای یادگیری ماشین سنتی در حل آنها ناتوان هستند را حل کرد که از آن جمله باید به تشخیص تصاویر، ترجمه ماشینی، تشخیص گفتار، تحلیل متن و غیره اشاره کرد. شبکههای عصبی عمیق قادر به یادگیری تصاویر، صداها، متون و سایر انواع دادهها هستند و میتوانند با دقت بالا پیچیدگیهای غیرخطی را نمایش دهند. از جمله معروفترین معماریهای شبکههای عصبی عمیق میتوان به شبکههای عصبی پیچشی (Convolutional Neural Networks) که برای تصاویر و ویدیوها استفاده میشوند و شبکههای عصبی بازگشتی (Recurrent Neural Networks) که برای دادههای دنبالهای مانند متون و گفتار استفاده میشوند، اشاره کرد. همچنین، شبکههای عصبی مولد مانند شبکههای مولد تخاصمی (Generative AdversarialNetworks) نیز در یادگیری عمیق مورد استفاده قرار میگیرند تا بتوانند دادههای جدید و واقعگرایانه ایجاد کنند. یادگیری عمیق با استفاده از کلان دادهها و قدرت پردازش ماشینها توانسته است به موفقیتهای چشمگیری در بسیاری از حوزههای مربوط به هوش مصنوعی، تشخیص الگو و پردازش دادههای پیچیده دست یابد.

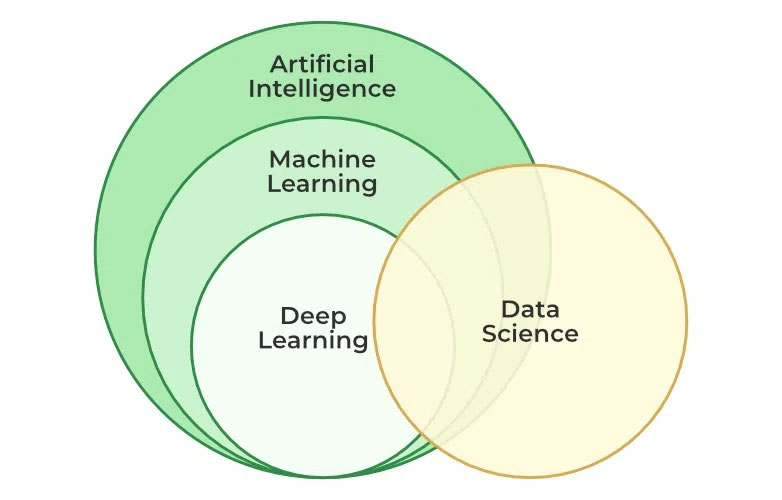

آشنایی با تعاریف هوش مصنوعی و یادگیری ماشین

هوش مصنوعی (Artificial Intelligence) یک حوزه تحقیقاتی گسترده است که به بررسی و تحقیق درباره طراحی و توسعه سیستمها و برنامههای کامپیوتری با قابلیت تفکر و عملکرد مشابه انسان میپردازد. هدف اصلی هوش مصنوعی، ایجاد سیستمهایی است که قادر به انجام وظایف هوشمندانه و حل مسایل پیچیده با استفاده از الگوریتمها و روشهای محاسباتی خاص باشند.

یادگیری ماشین (Machine Learning) یک زیرمجموعه از هوش مصنوعی است که به کامپیوترها امکان میدهد بدون برنامهریزی صریح و شفاف، از تجربه و دادههای ورودی یاد بگیرند و بهبود کنند. در یادگیری ماشین، الگوریتمها و مدلهای آماری مورد استفاده قرار میگیرند تا بر اساس دادههای آموزشی، الگوها و قوانین موجود در دادهها را شناسایی و برازش (دقت کنید برازش و نه پردازش) کنند. سپس با استفاده از این الگوها و قوانین، میتوانند پیشبینیها و تصمیمهایی را در مورد دادههای جدید ارائه دهند.

یادگیری ماشین به سه شکل اصلی زیر تقسیم میشود:

- یادگیری نظارت شده (Supervised Learning): در این روش، مدل با استفاده از دادههای ورودی و خروجی متناظرشان آموزش داده میشود. هدف اصلی در یادگیری نظارت شده، پیشبینی خروجیها برای دادههای جدید است.

- یادگیری بدون نظارت (Unsupervised Learning): در این روش، مدل بدون داشتن خروجیهای متناظر با دادهها، آموزش میبیند. هدف اصلی در یادگیری بدون نظارت، استخراج الگوها، ساختارها و روابط مخفی در دادهها است.

- یادگیری تقویتی (Reinforcement Learning) نیز یک شاخه دیگر از یادگیری ماشین است که بر اساس سیستمهای مبتنی بر پاداش و جریمه عمل میکند. در این روش، عامل (Agent) با تعامل با یک محیط و دریافت پاداشها و جریمهها، تلاش میکند رفتاری را یاد بگیرد که بیشترین پاداش را به دست آورد.

ترکیب هوش مصنوعی و یادگیری ماشین، بااستفاده از الگوریتمها و شبکههای عصبی عمیق، به ایجاد سیستمهای هوشمند و قادر به یادگیری و انجام وظایف پیچیده از جمله تشخیص تصاویر، ترجمه ماشینی، تشخیص گفتار، تحلیل متن و بسیاری دیگر را فراهم آورده است.

مفهوم Supervised Learning و Unsupervised Learning چیست؟

در یادگیری نظارت شده، دادههای ورودی به همراه برچسب یا خروجی مربوط (برچسبهای صحیح) در اختیار مدل قرار میگیرند. هدف این روش، آموزش مدل به گونهای است که بتواند برای دادههای جدید ورودی، خروجی یا برچسب صحیح را پیشبینی کند. به عبارت دیگر، مدل سعی میکند الگوها و قوانین موجود در دادههای آموزشی را بیابد تا بتواند دادههای جدید را به درستی دستهبندی کند یا پیشبینی کند.

مثالهایی از یادگیری نظارت شده عبارتند از:

- تشخیص تصاویر: مدل با دادن تصاویر به همراه برچسبهای آنها، میآموزد تا تصاویر جدید را دستهبندی کند (مثلا تشخیص گربه و سگ در تصاویر).

- ترجمه ماشینی: مدل با استفاده از جفت ترجمهشده جملات در زبانهای مختلف، میآموزد تا جملات جدید را به زبان مقصد ترجمه کند.

- تشخیص گفتار: مدل با دریافت نمونههایی از گفتار همراه با برچسبهای صوتی، میآموزد تا گفتار جدید را تشخیص دهد و تحلیل کند.

در یادگیری بدون نظارت، دادههای ورودی بدون برچسب یا خروجی مشخص در اختیار مدل قرار میگیرند. هدف اصلی در این روش، استخراج الگوها، ساختارها و روابط مخفی در دادهها است. در این حالت، مدل به صورت خودکار بدون هدایت برچسبها یا خروجیهای صحیح، الگوها و ارتباطات معنایی در دادهها را کشف میکند.

مثالهایی از یادگیری بدون نظارت عبارتند از:

- خوشهبندی (Clustering): مدل سعی میکند دادهها را به گروههای مشابه یا خوشههای مختلف تقسیم کند بدون داشتن اطلاعاتی درباره برچسبها.

- کاوش انجمنی (Association Mining): مدل تلاش میکند الگوها، روابط و انجمنهایی را کشف کند که در دادهها به طور میآیند، مانند محصولات مرتبط در یک سبد خرید.

- کاهش بعد (Dimensionality Reduction): مدل سعی میکند با حفظ اطلاعات مهم، تعداد ویژگیها یا ابعاد دادهها را کاهش دهد، به منظور سادهسازی و تجزیه و تحلیل آنها.

یادگیری بدون نظارت معمولا برای کشف الگوها و ساختارهای پنهان در دادهها استفاده میشود و میتواند مرحله اولیهای برای پیشپردازش دادهها قبل از استفاده از یادگیری نظارت شده باشد.

یادگیری عمیق چیست؟

یادگیری عمیق یا Deep Learning یک زیرشاخه از یادگیری ماشین است که بر پایه شبکههای عصبی مصنوعی عمیق تمرکز دارد. این روش، تلاش میکند ساختار و قابلیتهای مشابه مغز انسان را در مدلهای رایانهای برقرار کند تا بتواند به طور خودکار الگوها و ویژگیهای پیچیده را در دادهها شناسایی کند و وظایفی مانند تشخیص تصاویر، تشخیص گفتار، ترجمه ماشینی و پیشبینی را انجام دهد.

شبکههای عصبی عمیق، شبکههایی با ساختار لایهای هستند که از مجموعه از نورونها (واحدهای پردازشی) تشکیل شدهاند. این شبکهها شامل لایههای ورودی، لایههای پنهان (همچنین بهعنوان لایههای میانی) و لایههای خروجی هستند. هر نورون در یک لایه با وزنهایی که برای اتصالاتش تعیین میشود، با نورونهای لایه قبل و بعد ارتباط برقرار میکند. این شبکهها با استفاده از الگوریتمهای بهینهسازی (مانند پسانتشار خطا)، به صورت متمرکز و تدریجی، وزنها را تنظیم میکنند تا بتوانند نمونههای آموزشی را با دقت بالا تشخیص دهند و پیشبینی کنند.

یادگیری عمیق به دلیل قدرتش در استخراج ویژگیهای پیچیده و همچنین تواناییش در پردازش دادههای بزرگ، در بسیاری از حوزههای مختلف مورد استفاده قرار میگیرد. برخی از معروفترین معماریهای شبکههای عصبی عمیق شامل شبکههای عصبی وابسته به زمان (Recurrent Neural Networks)، شبکههای عصبی پیچشی (Convolutional Neural Networks) و شبکههای عصبی مولد (Generative Neural Networks) هستند.

مزیت اصلی یادگیری عمیق، توانایی آن در خودکار سازی فرآیند یادگیری و استفاده از دادههای بدون برچسب برای استخراج الگوها و نمایش دادهها است. این قابلیت به مدلها امکان میدهد تا با دادههای بزرگ و پیچیده کار کنند و عملکرد بهتری در تشخیص الگوها از خود نشان دهند. در این روش، شبکههای عصبی با تعداد زیادی لایه مخفی (عمیق) استفاده میشوند که قابلیت یادگیری و استخراج ویژگیهای پیچیده را دارند. یادگیری عمیق توانایی بالایی در تشخیص الگوها، تعبیه اطلاعات پنهان، و پیشبینی دادهها را دارد و در بسیاری از حوزههایی مانند تشخیص تصاویر، ترجمه ماشینی، تحلیل متن، تشخیص گفتار و بسیاری دیگر مورد استفاده قرار میگیرد.

شبکههای عصبی عمیق شامل لایههای مختلفی هستند که هر لایه شامل یک تعداد نورون (واحدهای پردازشی) است. لایههای ورودی اطلاعات را دریافت میکنند و آنها را به لایههای پنهان منتقل میکنند. در هر لایه پنهان، عملیات محاسباتی روی ورودیها انجام میشود و ویژگیهای جدید استخراج میشوند. سپس خروجی نهایی از طریق لایههای خروجی تولید میشود. آموزش شبکههای عصبی عمیق به وسیله پسانتشار خطا و الگوریتمهای بهینهسازی صورت میگیرد که وزنهای شبکه را تنظیم میکنند تا خطا در پیشبینی خروجی کمینه شود.

یادگیری عمیق به دلیل قدرتش در استخراج ویژگیهای پیچیده، قابلیتش در پردازش دادههای بزرگ و توانایی انجام وظایف پیچیده، در حوزههای مختلفی مانند بینایی کامپیوتری، پردازش زبان طبیعی، تحلیل دادهها و بسیاری دیگر استفاده میشود. همچنین، با پیشرفتهای اخیر در سختافزارهای گرافیکی و قدرت محاسباتی بالا، امکان آموزش و استفاده از شبکههای عصبی عمیق به طور گستردهتر فراهم شده است.

Deep Learning چگونه کار میکند؟

یادگیری عمیق بر پایه مدلهای شبکههای عصبی عمیق کار میکند. در اینجا، به طور کلی روند کار یادگیری عمیق را توضیح میدهم:

- جمعآوری و آمادهسازی داده: در ابتدا، دادههای آموزشی برای مدل جمعآوری و آمادهسازی میشوند. این شامل تمیزکاری دادهها، مقداردهی اولیه، نرمالسازی و تقسیم دادهها به دستههای آموزشی و آزمایشی است.

- ساختاردهی مدل: سپس، ساختار مدل شبکه عصبی عمیق تعریف میشود. این شامل نوع و ترتیب لایهها، تعداد نورونها در هر لایه و اتصالات بین لایهها است. معمولا شبکههای عصبی عمیق شامل لایههای ورودی، لایههای پنهان (همچنین به عنوان لایههای میانی) و لایههای خروجی میباشند.

- آموزش مدل: در این مرحله، مدل با استفاده از دادههای آموزشی آموزش داده میشود. این فرآیند شامل ارسال دادهها به مدل، محاسبه خروجی پیشبینی شده توسط مدل، محاسبه خطا بین خروجی پیشبینی شده و مقدار واقعی و استفاده از الگوریتم پسانتشار خطا برای بهروزرسانی وزنها در شبکه است. این روند تا زمانی که مدل به طور قابل قبولی عمل کند و خطا در حد مطلوبی باشد، تکرار میشود.

- ارزیابی مدل: پس از آموزش مدل، عملکرد آن با استفاده از دادههای آزمایشی ارزیابی میشود. معیارهایی مانند دقت، صحت، بازخوانی و سایر معیارهای مربوط به وظیفه مورد نظر برای ارزیابی عملکرد مدل استفاده میشوند.

- بررسی و بهبود مدل: در صورتی که عملکرد مدل قابل قبول نباشد، ممکن است نیاز به تغییرات و بهبودهایی در ساختار مدل، الگوریتم آموزش یا پارامترهای آموزشی داشته باشید. در این صورت، بررسی و بهبود مدل به منظور بهبود عملکرد آن انجام میشود.

- استفاده از مدل آموزش دیده: پس از آموزش و بهرویکرد یادگیری عمیق بر پایه شبکههای عصبی عمیق استوار است. در حقیقت، شبکههای عصبی عمیق یک سری از لایههای عصبی را به صورت پشت سر هم قرار میدهند تا اطلاعات را به صورت سلسله مراتبی استخراج کنند و نمایشهای با سطوح بالاتر و پیچیدگی بیشتر از دادهها ایجاد کنند. این روش به مدلسازی قدرتمند و توانایی یادگیری و تفسیر الگوهای پیچیده در دادهها منجر میشود.

اکنون اجازه دهید عملکرد هر یک از لایههای یادگیری عمیق را مورد بررسی قرار دهیم:

- لایه ورودی (Input Layer): این لایه وظیفه دریافت دادههای ورودی و انتقال آنها به لایههای بعدی را دارد. به عنوان مثال، در پردازش تصویر، پیکسلهای تصویر به عنوان ورودی به شبکه ارسال میشوند.

- لایههای پنهان (Hidden Layers): این لایهها میانجیگران اصلی در فرآیند استخراج ویژگیها هستند. هر لایه پنهان، اطلاعات را از لایه قبلی دریافت کرده و با استفاده از وزنها و توابع فعالسازی، اطلاعات را تبدیل و پردازش میکند و به لایه بعدی منتقل میکند. این فرایند تکرار میشود تا به لایه خروجی برسیم.

- لایه خروجی (Output Layer): این لایه نتیجه نهایی را تولید میکند. بسته به نوع وظیفه، مانند تشخیص تصویر، ترجمه ماشینی یا پیشبینی قیمت، تعداد و نوع نورونها در این لایه متفاوت است.

- توابع فعالسازی (Activation Functions): در هر لایه، توابع فعالسازی برای ایجاد غیرخطیت و عملکرد غیرخطی مورد استفاده قرار میگیرند. این توابع مانند ReLU سرنام (Rectified Linear Unit)، سیگموید (Sigmoid) و تانژانت هیپربولیک (Tanh) هستند.

- الگوریتم آموزش دهنده (Training Algorithm): برای آموزش شبکه، از الگوریتم پسانتشار خطا (Backpropagation) استفاده میشود. این الگوریتم، خطا را به صورت معکوس به عقب انتشار میدهد و وزنها را در لایههای مختلف بروزرسانی میکند تا خطا کمینه شود.

- تابع هزینه (Loss Function): تابع هزینه یک معیار است که بر اساس آن، عملکرد یک مدل هوش مصنوعی در پیشبینی یا دستهبندی دادهها ارزیابی میشود. تابع هزینه معیاری است که میزان اختلاف بین خروجی مدل و مقدار واقعی یا برچسبهای دادهها را اندازهگیری میکند. هدف اصلی استفاده از تابع هزینه، کمینه کردن این اختلاف بین خروجی مدل و مقدار واقعی است. برای این منظور، تابع هزینه باید به گونهای تعریف شود که در هنگام آموزش مدل، پارامترهای مدل به نحوی بهروزرسانی شوند که خطای کلی سیستم کاهش یابد. نوع و انتخاب تابع هزینه بستگی به نوع مساله هوش مصنوعی دارد.

چگونه ضریب خطای هوش مصنوعی را به حداقل برسانیم؟

کاهش خطای هوش مصنوعی (AI) به یک مسئله پیچیده و چند بعدی است که در آن بسیاری از عوامل مختلف تاثیر میگذارند. در ادامه، چند راهکار عمومی برای کاهش خطا در سیستمهای هوش مصنوعی را بررسی میکنیم:

- جمعآوری و تمیزکاری داده: دادههای ورودی برای سیستم هوش مصنوعی بسیار مهم هستند. بنابراین، جمعآوری دادههای کامل و متنوع و انجام تمیزکاری مناسب بر روی آنها از اهمیت بالایی برخوردار است. دادههای ناقص، تکراری، نویز یا ناقص با وظیفه مورد نظر میتوانند خطاهای زیادی در سیستم ایجاد کنند. بنابراین، باید مراقب بود و دادهها را پیش از استفاده به خوبی بررسی کرد.

- افزایش حجم و تنوع داده: یکی از راهکارهای معمول برای کاهش خطا در سیستمهای هوش مصنوعی، افزایش حجم و تنوع داده است. با داشتن دادههای بیشتر و متنوع، سیستم میتواند الگوها و قوانین بیشتری را درک کند و پیشبینیها و تصمیمگیریهای بهتری انجام دهد. در صورتی که دادههای کافی و متنوع در دسترس نباشد، میتوان از تکنیکهایی مانند تولید داده مصنوعی، تقویت داده (data augmentation) و استفاده از روشهای نمونهبرداری هوشمند استفاده کرد.

- انتخاب و طراحی ویژگیها: ویژگیها یا معیارهای استخراج شده از دادهها میتوانند تاثیر قابل توجهی در عملکرد سیستم هوش مصنوعی داشته باشند. انتخاب و طراحی ویژگیهای مناسب و خوب، کیفیت و دقت سیستم را به طور قابل توجهی بهبود میبخشد. برای انتخاب و طراحی ویژگیها، میتوان از روشهای مختلفی مانند تحلیل عاملی، تحلیل مؤلفههای اصلی (PCA)، و تکنیکهای یادگیری ماشین استفاده کرد.

- بهبود معماری مدل: معماری مدل شبکه عصبی میتواند نقش مهمی در کاهش خطا داشته باشد. انتخاب معماری مناسب بر اساس وظیفه مورد نظر و استفاده از تکنیکهای پیشرفته مانند شبکههای عصبی عمیق (Deep Neural Networks) و مدلهای بازگشتی (Recurrent Models) میتواند به کاهش خطا کمک کند. همچنین، استفاده از روشهایی مانند رگولاریزاسیون (Regularization)، جلوگیری از بیشبرازش (Overfitting)، و انتخاب مناسب پارامترها نیز میتواند به بهبود دقت مدل کمک کند.

- آموزش مناسب: فرایند آموزش و بهینهسازی مدل بسیار مهم است. استفاده از الگوریتمهای بهینهسازی مناسب، تنظیم درست نرخ یادگیری (learning rate)، استفاده از دستهبندی متعادل (balanced classification) و استفاده از روشهای یادگیری تقویتی (reinforcement learning) میتواند به کاهش خطا کمک کند. همچنین، میتوان از روشهای تقویتی مانند آموزش تقویتی با پاداش (reward-based training) و آموزش نیمهنظارتی (semi-supervised learning) نیز استفاده کرد.

- ارزیابی و تست مداوم: بررسی و ارزیابی مداوم عملکرد سیستم هوش مصنوعی بسیار مهم است. با ارزیابی دقیق و تست مداوم، میتوان خطاها و ضعفهای سیستم را شناسایی کرده و آنها را بهبود بخشید. ارزیابی مدل با استفاده از معیارهای دقت، بازخوانی (recall)، دقت (precision) و سایر معیارهای مربوطه میتواند به درک بهتر از قابلیتها و محدودیتهای سیستم کمک کند.

- ترکیب چند مدل (Ensemble): استفاده از روش ترکیب چند مدل (ensemble) میتواند به بهبود دقت و کاهش خطا کمک کند. با ترکیب پیشبینیهای چند مدل مختلف، میتوان دقت سیستم را بهبود داده و خطا را کاهش داد.

- آموزش مداوم: هوش مصنوعی میتواند با زمان بهبود یابد. امکانات آموزش مداوم برای مدلهای هوش مصنوعی، مانند آموزش فزاینده (incremental learning) و تنظیم پارامترها بازنگری شده (parameter fine-tuning)، میتواند به بهبود کیفیت و دقت سیستم کمک کند.

تفاوت یادگیری ماشین با یادگیری عمیق چیست؟

یادگیری ماشین (Machine Learning) و یادگیری عمیق (Deep Learning) هر دو زیرمجموعههایی از حوزه هوش مصنوعی هستند، اما با تفاوتهای مهمی در روش و رویکرد خود به مسایل دادهها و مدلسازی روبهرو هستند.

یادگیری ماشین معمولا به روشهایی اشاره میکند که متکی بر الگوریتمهای آماری و ریاضی هستند و به کمک آنها مدلهایی برای تشخیص الگوها و قوانین موجود در دادهها ساخته میشود. در این روش، ویژگیهای دستیابی به دادهها به صورت دستی تعریف میشوند و بهعنوان ورودی به مدل داده میشوند. مثالهایی از الگوریتمهای یادگیری ماشین شامل ماشین بردار پشتیبان (SVM)، درخت تصمیم (Decision Tree) و رگرسیون خطی (Linear Regression) هستند.

از سوی دیگر، یادگیری عمیق بر اساس شبکههای عصبی مصنوعی عمیق استوار است. در این روش، شبکههای عصبی با تعداد زیادی لایه (عموما بیش از یک لایه مخفی) برای استخراج ویژگیهای از پیش تعیین نشده از دادهها استفاده میشوند. در این روش، شبکههای عصبی به صورت خودکار و بدون نیاز به تعریف دستی ویژگیها، ویژگیهای مناسب را میآموزند. این قابلیت به شبکههای عصبی عمیق اجازه میدهد تا در مسایل پیچیده و دادههای بزرگ به عملکرد بهتری دست یابند. مثالهایی از معماریهای یادگیری عمیق شامل شبکههای عصبی پیچشی (Convolutional Neural Networks) برای تصویربرداری و شبکههای عصبی بازگشتی (Recurrent Neural Networks) برای پردازش دادههای دنبالهای مانند متن هستند. بنابراین، تفاوت اصلی بین یادگیری ماشین و یادگیری عمیق در استفاده از شبکههای عصبی عمیق و قدرت آنها در استخراج ویژگیهای پیچیده و همچنین توانایی آموزش بدون نیاز به تعریف دستی ویژگیها است.

بدون دیدگاه