شبکه عصبی بازگشتی (Recurrent Neural Network) یک نوع از شبکههای عصبی است که برای پردازش دادههای دنبالهای وابسته به زمان استفاده میشود. این شبکه در نقطه مقابل شبکههای عصبی Feedforward Neural Networks قرار دارد که اطلاعات را از ورودی به خروجی به صورت یکطرفه منتقل میکنند، شبکه عصبی بازگشتی قابلیت حفظ و استفاده از حالتهای گذشته را دارد. ساختار اصلی شبکه عصبی بازگشتی شامل یک یا چند واحد بازگشتی است که با یکدیگر در ارتباط هستند. این ارتباط باعث میشوند که اطلاعات در طول زمان در شبکه جریان داشته باشند و فرآیند پردازش دادهها به شکل دقیقی انجام شود.

یکی از معروفترین شبکههای عصبی بازگشتی LSTM سرنام (Long Short-Term Memory) است که برای حل مشکل محوشدگی گرادیان در شبکههای عصبی بازگشتی سنتی طراحی شده است. LSTM با استفاده از واحدهای خاصی به نام “سلول” (cell) که دارای سه دروازه است، قادر به یادگیری و حفظ اطلاعات بلندمدت و انجام عملیات است. این ویژگیها باعث میشود که LSTM به خوبی برای پردازش دادههای دنبالهای و سری زمانی مناسب باشد. شبکههای عصبی بازگشتی میتوانند در بسیاری از وظایف مرتبط با دادههای دنبالهای مانند ترجمه ماشینی، تشخیص گفتار، تولید متن، تحلیل سیگنالهای زمانی و پیشبینی سریهای زمانی استفاده شوند. آنها به عنوان یکی از ابزارهای قوی در حوزه یادگیری عمیق و هوش مصنوعی شناخته میشوند.

چه نوع وظایفی را میتوان با استفاده از شبکه عصبی بازگشتی انجام داد؟

شبکههای عصبی بازگشتی (RNN) میتوانند در بسیاری از پروژهها مورد استفاده قرار گیرند، با این حال به شکل گستردهای در پروژههای زیر مورد استفاده قرار میگیرند.

- ترجمه ماشینی: شبکههای عصبی بازگشتی میتوانند برای ترجمه متون از یک زبان به زبان دیگر استفاده شوند. با آموزش بر روی جفت دادههای ترجمه شده، این شبکهها قادر به تولید ترجمههای معقول و زبانبندی صحیح هستند.

- تشخیص گفتار: با استفاده از دادههای صوتی و آموزش روی آنها، شبکههای عصبی بازگشتی قادر به تشخیص گفتار و تبدیل آن به متن هستند. این وظیفه در سیستمهای تشخیص صدا، تبدیل متن به گفتار، تایپ صوتی و سیستمهای ترجمه صوتی استفاده میشود.

- تولید متن: با آموزش بر روی دادههای متنی، شبکههای عصبی بازگشتی قادر به تولید متن جدید بر اساس الگوهای یادگرفته شده هستند. این شبکهها میتوانند برای تولید شعر، اخبار، متون خلاقانه و حتی موسیقی استفاده شوند.

- پیشبینی سریهای زمانی: شبکههای عصبی بازگشتی گزینه مناسبی برای پیشبینی سریهای زمانی هستند. به طوری که امکان استفاده از آنها در ارتباط با پیشبینی ارزش سهام در بورس، پیشبینی آب و هوا، مدلسازی ترافیک و سیستمهای پیشبینی الگوی مصرف انرژی وجود دارد.

معماری شبکه عصبی بازگشتی چیست؟

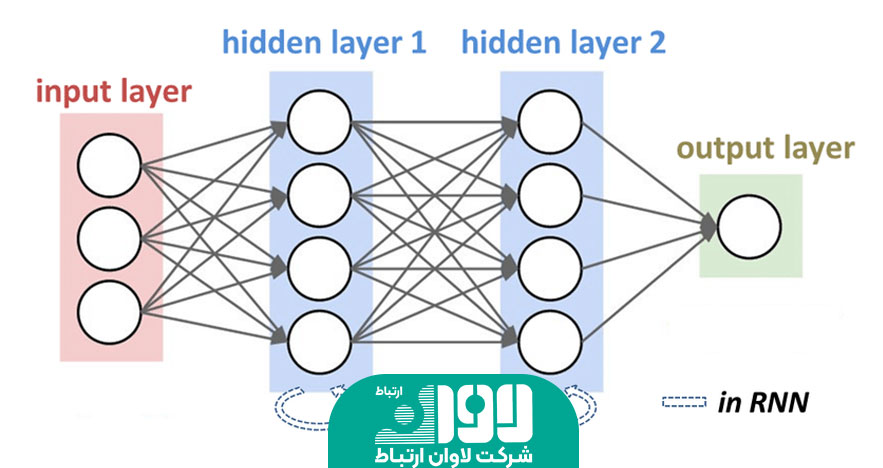

معماری شبکه عصبی بازگشتی (RNN) شامل تعدادی واحد بازگشتی است که به صورت متوالی در زمان اجرا به یکدیگر متصل میشوند. هر واحد بازگشتی، ورودی را دریافت کرده و خروجی را تولید میکند و همچنین وضعیت داخلی را در طول زمان حفظ میکند تا اطلاعات قبلی را نگه دارد و در فرآیند بعدی استفاده کند. به طور معمول، هر واحد بازگشتی در شبکه RNN شامل سه لایه اصلی است: ورودی (input layer)، واحد مخفی (hidden unit) و لایه خروجی (output layer) است. لایه ورودی شبکه عصبی بازگشتی، دادههای ورودی را در هر زمان t دریافت میکند. واحد پنهان، اطلاعات قبلی که در حالت داخلی نگهداری میشود را دریافت میکند و با اطلاعات ورودی جدید ترکیب میکند تا خروجی را تولید کند. سپس خروجی نهایی شبکه به عنوان خروجی در زمان t در نظر گرفته میشود.

در شبکه RNN، اتصالات بین واحدهای بازگشتی اجازه میدهند تا اطلاعات در طول زمان جریان داشته باشند. به عبارت دیگر، خروجی واحد بازگشتی در زمان t نه تنها به عنوان خروجی در زمان t مورد استفاده قرار میگیرد، بلکه به عنوان ورودی واحد بازگشتی در زمان t+1 نیز استفاده میشود. این روابط باعث میشوند که شبکه RNN به خوبی بتواند الگوهای زمانی پیچیده را در دادههای دنبالهای یاد بگیرد. به طور خلاصه، معماری شبکه RNN شامل تعدادی واحد بازگشتی متصل به یکدیگر است. هر واحد بازگشتی اطلاعات ورودی را دریافت کرده، با اطلاعات قبلی ترکیب میکند و خروجی را تولید میکند. این ویژگی باعث میشود که RNN بتواند الگوهای زمانی پیچیده را در دادههای دنبالهای یاد بگیرد.

لایه ورودی (input layer) در شبکه RNN

در معماری شبکه عصبی بازگشتی (RNN)، لایه ورودی (input layer) وظیفه دریافت دادههای ورودی در هر زمان مشخص را برعهده دارد. این لایه اطلاعات ورودی را از فضای ورودی (input space) دریافت کرده و آنها را به واحدهای بازگشتی شبکه ارسال میکند. لایه ورودی معمولا به صورت یک بردار ورودی با ابعاد مشخص تعریف میشود. برای مثال، اگر دادههای ورودی ما در قالب یک دنباله از بردارها با طول زمانی T باشد، بردار ورودی در هر زمان t یک بردار با ابعاد مشخص مانند (d,) خواهد بود. این بردار میتواند شامل ویژگیهای ورودی در زمان t باشد. هر واحد بازگشتی در شبکه RNN، ورودی خود را از لایه ورودی دریافت میکند و با اطلاعات قبلی که در حالت داخلی خود نگه میدارد ترکیب میکند تا خروجی را تولید کند. بنابراین، لایه ورودی با تامین ورودی مناسب برای واحدهای بازگشتی، نقش اساسی در عملکرد شبکه RNN ایفا میکند. نکته مهمی که باید در نظر داشته باشید این است که در شبکه RNN، لایه ورودی به طور معمول برای هر زمان t یک ورودی جداگانه دریافت میکند و اطلاعات زمان قبلی در خود نگهداری نمیکند. برای استفاده از اطلاعات زمان گذشته در شبکه RNN، نیاز به واحدهای بازگشتی است که میتوانند این اطلاعات را در طول زمان حفظ کرده و استفاده کنند.

واحد مخفی (hidden unit) در شبکه RNN

واحد پنهان (hidden unit) در شبکه عصبی بازگشتی (RNN) به عنوان بخش کلیدی در شبکه RNN در نظر گرفته میشود. هر واحد پنهان در واقع یک حالت داخلی (internal state) دارد که اطلاعاتی از ورودیهای قبلی را نگه میدارد و در فرآیند بعدی استفاده میکند. وظیفه اصلی واحد مخفی در شبکه RNN، ادغام اطلاعات ورودی جدید با حالت داخلی قبلی است. در هر زمان t، لایه پنهان اطلاعات ورودی جدید را از لایه ورودی دریافت میکند و با حالت داخلی قبلی که نگهداری میشود ترکیب میکند. این ترکیب اطلاعات به لایه مخفی کمک میکند تا الگوهای زمانی پیچیده را در دادههای دنبالهای تشخیص دهد.

روابط بین لایههای پنهان ر شبکه RNN اجازه میدهند تا اطلاعات در طول زمان جریان داشته باشند. به عبارت دیگر، خروجی لایه پنهان در زمان t نه تنها به عنوان خروجی در زمان t مورد استفاده قرار میگیرد، بلکه به عنوان ورودی واحد پنهان در زمان t+1 نیز استفاده میشود. این ویژگی باعث میشود که شبکه RNN بتواند الگوهای زمانی در دادههای دنبالهای را یاد بگیرد و اطلاعات قبلی را در فرآیند بعدی استفاده کند. تعداد لایههای پنهان در شبکه RNN به طراحی شبکه و مساله مورد نظر بستگی دارد. از طریق تغییر تعداد لایههای پنهان میتوانید میزان توانایی شبکه RNN در یادگیری الگوهای زمانی پیچیده را تغییر دهید. با افزایش تعداد لایههای پنهان شبکه قادر به نگهداری و استفاده از اطلاعات بیشتر از گذشته خواهد بود، اما همزمان پیچیدگی محاسباتی نیز افزایش خواهد یافت.

لایه خروجی (output layer) در شبکه RNN

لایه خروجی (output layer) در شبکه عصبی بازگشتی مسئول تولید خروجی در هر زمان مشخص است. این لایه اطلاعاتی از لایههای پنهان دریافت کرده و بر اساس آنها، خروجی مورد نظر را تولید میکند. لایه خروجی معمولا به صورت یک بردار خروجی با ابعاد مشخص تعریف میشود. برای مثال، اگر در یک مساله دنبالهای، بردار ورودی در هر زمان t با ابعاد (d,) باشد، بردار خروجی در هر زمان t نیز میتواند یک بردار با ابعاد مشابه یا متفاوت باشد. روشهای مختلفی برای تولید خروجی در شبکه RNN وجود دارد. به طور معمول استفاده از لایه تمام متصل (fully connected layer) برای تبدیل ویژگیهای استخراج شده از لایههای مخفی به بردار خروجی رایج است. این لایه میتواند شامل تابع فعالسازی خاصی باشد، مانند تابع softmax برای مسایل دستهبندی یا تابع خطی برای مسایل رگرسیون باشد. در بعضی از موارد، ممکن است لایه خروجی در هر زمان t اطلاعاتی از حافظه داخلی لایه پنهان در زمان t را نیز دریافت کند. این اطلاعات میتوانند به عنوان اطلاعات مکملی برای تولید خروجی مورد استفاده قرار بگیرند.

همچنین، در بعضی از معماریهای پیشرفته RNN، میتوان بیش از یک لایه خروجی داشت. در این صورت، هر لایه خروجی میتواند خروجی مستقل خود را تولید کند و به عنوان ورودی برای لایههای دیگر استفاده شود. این نوع معماریها، مانند شبکه عصبی بازگشتی چند لایهای (multi-layer RNN) یا شبکه عصبی بازگشتی مبتنی بر توجه (attention-based RNN)، به شبکه RNN امکان یادگیری الگوهای پیچیدهتر و بهتر را میدهند.

وزنها در RNN

در شبکه عصبی بازگشتی، وزنها (weights) نقش بسیار مهمی در عملکرد و یادگیری دارند. وزنها در RNN برای اتصال و تعامل بین لایهها و واحدهای مخفی مورد استفاده قرار میگیرند. وزنها در RNN به صورت ماتریسهای وزنی تعریف میشوند. در واقع، هر لایه پنهان با همه لایههای قبلی و خودش بر مبنای این وزنها ارتباط برقرار میکند. بنابراین، برای هر لایه پنهان یک ماتریس وزنی با ابعاد مناسب دارد که در آن وزنهای مربوط به اتصالات با لایههای قبلی قرار دارند. همچنین، برای اتصال لایه ورودی به لایه پنهان نیز یک ماتریس وزنی وجود دارد. این ماتریس وزنی برای تبدیل ویژگیهای ورودی به فضای ویژگیهای لایههای پنهان استفاده میشود.

در شبکه RNN، وزنها معمولا به صورت تصادفی مقداردهی اولیه میشوند و سپس در فرآیند آموزش با استفاده از الگوریتم پسانتشار خطا (backpropagation) و روشهای بهینهسازی مانند گرادیان کاهشی (gradient descent) بهبود مییابند. در هر مرحله از آموزش، وزنها بر اساس خطا و گرادیان محاسبه شده بروزرسانی میشوند تا شبکه بهبود یابد و بهترین وزنها برای دستهای از دادهها را یاد بگیرد. به طور معمول، در شبکه RNN، ماتریس وزنی برای اتصالات بین لایههای مخفی در زمانهای مختلف یکسان است و از یک مجموعه وزن مشترک استفاده میشود. این وزنها به عنوان وزنهای بازتابی (recurrent weights) شناخته میشوند. همچنین، وزنهایی برای اتصال لایه ورودی به لایه پنهان و همچنین برای اتصال لایه پنهان به لایه خروجی نیز وجود دارد. در معماریهای پیشرفتهتر RNN مانند LSTM و GRU سرنام (Gated Recurrent Unit) ساختار وزنها متفاوت است و از طریق ساختارهای خاصی کنترل و تنظیم میشوند تا به مشکل تلاش برای حفظ اطلاعات در طول زمان در RNN معمولی پاسخ دهند.

انتشار رو به جلو

انتشار رو به جلو (Feedforward) یک روش محاسباتی است که در شبکههای عصبی استفاده میشود. در این روش، اطلاعات از لایه ورودی به سمت لایه خروجی جریان مییابند، بدون انتقال به عقب و بدون استفاده از حالت قبلی. فرآیند انتشار رو به جلو در یک شبکه عصبی با چند لایه (مانند شبکههای عصبی پرسپترون چند لایه) به شکل زیر انجام میشود:

- ورودی: اطلاعات ورودی، مانند ویژگیهای ورودی، به شبکه عصبی داده میشوند.

- محاسبه خروجی لایههای پنهان: ورودی به لایههای پنهان منتقل میشوند و در هر لایه پنهان، وزنها و توابع فعالسازی محاسبه میشوند. سپس، خروجی هر لایه پنهان به لایه بعدی منتقل میشود.

- محاسبه خروجی لایه پنهان: خروجی لایههای پنهان به لایه خروجی منتقل میشوند و خروجی نهایی شبکه عصبی را تشکیل میدهند. در لایه خروجی، معمولا از تابع فعالسازی مشخصی استفاده میشود که نوع مساله مورد نظر را تعیین میکند (مانند تابع softmax برای مسایل دستهبندی).

- محاسبه خطای پیشبینی: خروجی تولید شده با خروجی مورد انتظار مقایسه میشود و خطای پیشبینی محاسبه میشود. این خطا میتواند با استفاده از معیارهای مختلفی مانند خطای میانگین مربعات (Mean Squared Error) یا خطای آنتروپی متقاطع (Cross-Entropy Error) محاسبه شود.

- بهبود وزنها: با استفاده از روشهای بهینهسازی مانند گرادیان کاهشی (Gradient Descent) و پسانتشار خطا (Backpropagation)، وزنها در شبکه عصبی بهبود داده میشوند تا خطای پیشبینی کمینه شود. این فرآیند شامل محاسبه گرادیان خطا نسبت به وزنها و بهروزرسانی آنها است.

- تکرار مراحل 2 تا 5: فرآیند محاسباتی از لایه ورودی به لایه خروجی تکرار میشود تا خطای پیشبینی به حداقل برسد و وزنها بهبود یابند.

در مجموع، انتشار رو به جلو یک روش محاسباتی است که در شبکههای عصبی با چند لایه استفاده میشود. این روش معمولا برای مسایلی که نیاز به پیشبینی یا تصمیمگیری در لحظه فعلی بدون استفاده از حالت قبلی دارند، مناسب است.

فرایند پس انتشار

فرایند پسانتشار (Backpropagation) یک الگوریتم محاسباتی است که در شبکههای عصبی با چند لایه استفاده میشود. این الگوریتم برای بهبود وزنها در شبکه عصبی و کاهش خطا استفاده میشود. فرایند پسانتشار در چند مرحله به شرح زیر انجام میشود.

- انتشار خطا به عقب: در این مرحله، خطا از خروجی شبکه به سمت عقب منتشر میشود. ابتدا، خطای پیشبینی محاسبه شده در لایه خروجی با استفاده از تابع خطا مقایسه میشود. سپس، خطا به سمت لایههای قبلی منتشر میشود، به این صورت که خطا مرتبط با هر واحد در لایهها قبلی محاسبه میشود.

- محاسبه گرادیان: بعد از انتشار خطا به عقب، گرادیان خطا نسبت به وزنها محاسبه میشود. این گرادیان نشان میدهد که چقدر تغییر در خطا به تغییر در هر وزن مربوط است. برای محاسبه گرادیان، از قاعده زنجیرهای (Chain Rule) استفاده میشود.

- بهروزرسانی وزنها: پس از محاسبه گرادیان، وزنها بهروزرسانی میشوند تا بهبود یابند. این بهروزرسانی معمولا با استفاده از روشهای بهینهسازی مانند کاهش گرادیان (Gradient Descent) انجام میشود. در این روش، گرادیان گرفته شده در مرحله قبل در جهت کاهش خطا استفاده میشود تا وزنها بهینه شوند.

- تکرار مراحل 1 تا 3: فرآیند پسانتشار معمولا تا زمانی که خطای پیشبینی به حداقل برسد یا زمانی که تعداد مشخصی از تکرارها انجام شود، تکرار میشود. این فرایند مراحل انتشار خطا به عقب، محاسبه گرادیان و بهروزرسانی وزنها را تکرار میکند تا شبکه بهبود یابد و خطای پیشبینی کمینه شود.

با استفاده از فرایند پسانتشار، شبکه عصبی قادر است خطا را به سمت لایههای قبلی منتشر کرده و وزنها را به گونهای بهروزرسانی کند که خطای پیشبینی کمینه شود.

مشکل محو شدگی گرادیان در شبکه عصبی بازگشتی چیست؟

مشکل محو شدگی گرادیان (Vanishing Gradient Problem) یکی از مشکلات شبکههای عصبی بازگشتی (Recurrent Neural Networks – RNNs) است. در این حالت، هنگام پسانتشار خطا در شبکه عصبی بازگشتی، گرادیانها به لایههای ورودی نسبت به زمانهای گذشته به صورت نامطلوب کاهش مییابند، به طوری که گرادیانها به سمت لایههای اولیه میل میکنند و به تقریبا صفر محدود میشوند. این موضوع باعث میشود که وزنهای مربوط به لایههای اولیه بهروزرسانی نشوند و فرایند یادگیری به درستی انجام نشود. محو شدگی گرادیان معمولا در شبکههای عصبی بازگشتی با توابع فعالسازی مانند تابع سیگموید (Sigmoid) یا تانژانت هایپربولیک (Hyperbolic Tangent) رخ میدهد. این توابع فعالسازی دارای محدوده خروجی بین 0 و 1 (در صورت استفاده از سیگموید) یا بین -1 و 1 (در صورت استفاده از تانژانت هایپربولیک) هستند. وقتی که خروجی لایه بازگشتی به یک مقدار بسیار کوچک نزدیک میشود، گرادیانها به صورت تقریبی صفر میشوند و به لایههای قبلی منتقل نمیشوند.

این مشکل میتواند باعث کاهش سرعت یادگیری و عدم توانایی شبکه در یادگیری الگوهای بلندمدت وابسته به زمان شود. در صورتی که در یک شبکه عصبی بازگشتی، اطلاعات مهم در زمانهای گذشته ذخیره شده باشند، محو شدگی گرادیان میتواند باعث از بین رفتن این اطلاعات و عدم انتقال آنها به لایههای بعدی شود.

برای مقابله با مشکل محو شدگی گرادیان در شبکههای عصبی بازگشتی، روشهای مختلفی وجود دارد. برخی از راهحلها شامل استفاده از توابع فعالسازی متفاوتی مانند تابع ReLU، استفاده از شبکههای عصبی بازگشتی با واحدهای حافظه (LSTM) یا شبکههای عصبی بازگشتی با واحدهای زمانی (GRU) و استفاده از روشهای نرمالسازی گرادیان مثل (Vanishing Gradient Problem) است.

چگونه شبکه عصبی بازگشتی را پیاده سازی کنیم؟

برای پیادهسازی یک شبکه عصبی بازگشتی، میتوانید از کتابخانهها و فریمورکهای موجود در زبان برنامهنویسی مورد علاقهتان استفاده کنید. به طور کلی روش پیادهسازی یک شبکه عصبی بازگشتی به شرح زیر است، اما در نظر داشته باشید که جزییات پیادهسازی ممکن است بسته به کتابخانه یا فریمورکی که استفاده میکنید، متفاوت باشد.

- وارد کردن کتابخانهها: ابتدا باید کتابخانههای مورد نیاز را وارد کنید. معمولا از کتابخانههایی مانند TensorFlow، PyTorch یا Keras برای پیادهسازی شبکه عصبی بازگشتی استفاده میشود. بسته به زبان برنامهنویسی خود، ممکن است نیاز به نصب کتابخانهها باشد.

- تعریف معماری شبکه: باید ساختار و معماری شبکه عصبی بازگشتی را تعریف کنید که شامل تعیین تعداد لایههای مخفی، تعداد واحدها در هر لایه، توابع فعالسازی، و توصیف مسیر جریان داده در شبکه است. معمولا از لایههای RNN مانند LSTM یا GRU استفاده میشود.

- تعیین توابع هزینه و بهبود: باید تابع هزینه یا تابع معیاری را تعیین کنید که میزان خطا را اندازهگیری میکند. همچنین باید یک الگوریتم بهبود مانند بهینهسازی گرادیان نیز تعیین کنید.

- آموزش مدل: برای آموزش مدل، باید دادههای آموزشی را به شبکه عصبی وارد کرده و مدل را بر اساس آنها آموزش دهید. این فرآیند شامل تکرار چرخههای آموزشی، پسانتشار خطا و بهروزرسانی وزنها است. همچنین، میتوانید از روند آموزش مستمر استفاده کنید و به ازای هر دوره آموزشی عملکرد مدل را ارزیابی کنید.

- ارزیابی مدل: پس از آموزش، باید مدل را بر روی دادههای آزمون یا اعتبارسنجی بررسی کنید. این کار به شما امکان میدهد کیفیت عملکرد مدل را ارزیابی و هدف اصلی پیادهسازی یک شبکه عصبی بازگشتی (RNN)، درک و استفاده از الگوهای زمانی در دادهها را انجام دهید. در این شبکهها، اطلاعات از حالت قبلی به لایههای بعدی منتقل میشوند و این امکان را میدهد تا مدل بتواند به وابستگیهای زمانی در دادهها پاسخ دهد.

یکی از روشهای معروف برای پیادهسازی RNN، استفاده از یکی از کتابخانههای محبوب مانند TensorFlow یا PyTorch است. در ادامه، روند سادهای برای پیادهسازی RNN با استفاده از TensorFlow را بررسی میکنیم:

- وارد کردن کتابخانهها:

import tensorflow as tf

- تعریف معماری شبکه:

model = tf.keras.Sequential()

model.add(tf.keras.layers.SimpleRNN(units=64, input_shape=(timesteps, input_dim)))

در این مثال، از یک لایه RNN ساده با 64 واحد استفاده شده است. شما میتوانید لایههای دیگری مانند LSTM یا GRU را نیز استفاده کنید.

- تعیین توابع هزینه و بهبود:

model.compile(loss=’mse’, optimizer=’adam’)

در این مثال، از تابع خطای میانگین مربعات (MSE) برای تابع هزینه و از الگوریتم بهبود Adam استفاده شده است. شما میتوانید توابع هزینه و بهبود دیگری را نیز انتخاب کنید.

- آموزش مدل:

model.fit(X_train, y_train, epochs=10, batch_size=32)

در این مثال، دادههای آموزشی X_train و برچسبهای متناظر y_train به شبکه داده میشوند و مدل به مدت 10 دوره با دستهبندی برچسبهای بستههای 32 تمرین میکند.

- ارزیابی مدل:

y_pred = model.predict(X_test)

در این مثال، دادههای آزمون X_test به مدل داده میشوند. اکنون میتوانید از خروجی پیشبینی شده y_pred استفاده کنید.

مشکل اصلی شبکه عصبی بازگشتی چیست؟

مشکل اصلی شبکه عصبی بازگشتی محوشدگی گرادیان است. این مشکل در فرآیند آموزش RNN به وجود میآید و باعث میشود که گرادیانها به عقب در زمان حرکت کرده و ناپدید شوند و اطلاعات اشتباهی را ارائه کنند. به طور ساده، هنگامی که شبکه عصبی بازگشتی با تعداد زیادی لایه مخفی مواجه میشود، گرادیانها به طور تدریجی کاهش مییابند و به لایههای اولیه بسیار کوچک تبدیل میشوند که باعث کاهش توانایی شبکه در یادگیری و درک وابستگیهای زمانی در دادهها میشود.

همانگونه که اشاره شد برای حل مشکل محوشدگی گرادیان روشهای مختلفی مانند استفاده از خروجیهای واحدهای بازگشتی (GRU) و شبکههای حافظه طولانی کوتاهمدت (LSTM)، استفاده از تابع فعالسازی ReLU، استفاده از روشهای نرمالیزه کردن گرادیان (مانند گرادیان کاهشیافته) و استفاده از شبکههای عصبی بازگشتی دوطرفه (Bidirectional RNN) وجود دارد. این روشها به شبکه عصبی بازگشتی کمک میکنند تا اطلاعات زمانی را به شکل موثرتری حفظ کنند و عملکردش بهبود قابل توجهی پیدا کند.

بدون دیدگاه