Overfitting

زمان خواندن: 18 دقیقه

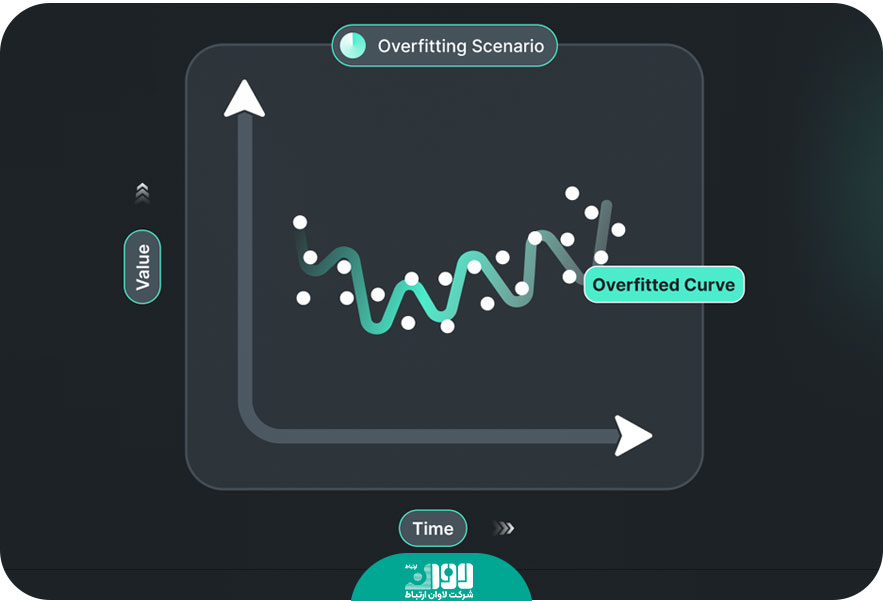

بیشبرازش (Overfitting) یک مشکل در یادگیری ماشین است و زمانی رخ میدهد که یک مدل آموزش دیده بیش از حد پیچیده شود و به صورت دقیق به دادههای آموزشی خود بسنده کند، به طوری که نتواند به طور کلی الگوها و قوانین عمومی را درک کند. به عبارت دیگر، مدل در فرآیند یادگیری به اندازه کافی خوب عمومیسازی نمیکند، بلکه به طور نسبی به دادههای آموزشی خود overfit میشود. وقتی یک مدل Overfit میشود، عملکرد آن بر روی دادههای آموزشی به خوبی است، اما در مواجهه با دادههای جدید (تست یا ورودی واقعی) عملکرد ضعیفی دارد. دلیل این اتفاق این است که مدل با جزئیات و نویزهای موجود در دادههای آموزشی بیش از حد سازگار میشود و قوانین عمومی را درک نمیکند.

دلایل بروز مشکل Overfitting

بیشبرازش به دلایل مختلفی به وجود میآید. اولین مورد کم بودن دادهها است. وقتی تعداد دادههای آموزشی کمتر از حد نیاز یا پیچیدگی مدل زباد باشد، احتمال بروز بیشبرازش افزایش مییابد. در این صورت، مدل به طور طبیعی تلاش میکند تا تمام جزییات دادههای آموزشی را حفظ کند و نتیجه آن ضعف اطلاعات عمومی است. استفاده از مدلهای پیچیده و قدرتمند، مانند شبکههای عصبی عمیق، میتواند به بروز بیشبرازش منجر شود. این مدلها توانایی بیشتری برای یادگیری جزییات و نویزها دارند و ممکن است به جای یادگیری الگوهای عمومی، با جزییات نویزی در دادههای آموزشی هماهنگ شوند. وقتی توزیع دادهها نامتعادل است، این مشکل به وجود میآید. به بیان دقیقتر، هنگامی که تعداد نمونهها در هر دسته متفاوت باشد، بیشبرازش رخ دهد. این موضوع میتواند زمانی رخ دهد که تعداد نمونههای یک دسته بسیار کمتر یا بسیار بیشتر از دسته دیگر باشد. در این صورت، مدل ممکن است به دسته اکثریت بیشتر توجه کند و دسته اقلیت را به درستی تشخیص ندهد.

استفاده از ویژگیهای غیرضروری و نامناسب میتواند به بروز بیشبرازش منجر شود. وقتی ویژگیها به طور نامناسب انتخاب شوند، مدل ممکن است به جزئیات غیرضروری در دادههای آموزشی توجه کند و عمومیسازی نکند. در نهایت، بروز بیشبرازش میتواند به دلیل ترکیبی از عوامل فوق یا عوامل دیگری که در فرآیند آموزش و تنظیم مدل تاثیر میگذارند، رخ دهد.

چگونه مانع از بروز مشکل Overfitting شویم؟

برای جلوگیری از بروز مشکل بیشبرازش (Overfitting) در مدلهای یادگیری ماشین، روشها و تکنیکهای مختلفی در دسترس قرار دارند. اولین مورد افزایش تعداد دادهها است. با افزایش تعداد دادههای آموزشی، مدل توانایی کلیتبخشی بیشتری پیدا میکند و به جزییات نویزی در دادهها وابسته نمیشود. در صورت امکان، بهتر است تعداد دادههای آموزشی را افزایش دهید. روشهای منظمسازی مانند Dropout و L1 یا L2 Regularization قادر به کاهش بیشبرازش هستند. این روشها با کاهش پیچیدگی مدل و کنترل پارامترها به مدل اجازه میدهند اطلاعات عمومی را به شکل بهتری درک کند. همچنین، با استفاده از تکنیک Dropout، در هر مرحله از آموزش، تصادفی برخی از واحدهای شبکه عصبی غیرفعال میشوند. این تکنیک باعث کاهش اتصالات میان واحدها میشود و برخی از ویژگیهای افراطی را نادیده میگیرد.

راهکار دیگر استفاده از یک مجموعه اعتبارسنجی متقابل (Cross-validation) است. با استفاده از مجموعه اعتبارسنجی متقابل، میتوانید عملکرد مدل را بررسی کنید. این روش به شما اجازه میدهد تا مدل خود را بر روی بخشی از دادهها آموزش دهید و سپس بر روی بخش دیگری اعتبارسنجی کنید. این رویکرد برای ارزیابی عملکرد مدل در ارتباط با دادههایی که قبلا دیده نشدهاند مفید است. در بعضی موارد، پیچیدگی مدل میتواند منجر به بیشبرازش شود. بنابراین، میتوانید از مدلهای سادهتر و کمپارامترتر استفاده کنید تا از این مشکل جلوگیری کنید. انتخاب ویژگیهای مناسب و حذف ویژگیهای غیرضروری میتواند به جلوگیری از بروز مشکل بیشبرازش کمک کند. با انتخاب ویژگیهای مهم و اصلی، مدل تمرکز خود را بر روی اطلاعات حیاتی حفظ میکند و از جزئیات غیرضروری صرف نظر میکند. راهکار قدرتمند دیگر با استفاده از تکنیکهای انتقال یادگیری است. میتوانید از یک مدل پیشآموزش دیده بر روی دادههای بزرگتر یا متفاوت استفاده کنید و سپس آن را برای مساله خاص خود تنظیم کنید. این روش به شما کمک میکند تا از دانش کلی مدل پیشآموزش دیده برای بهبود عملکرد مدل خود در مساله خاص استفاده کنید و از بیشبرازش جلوگیری کنید. در نهایت راهکار دیگر استفاده از تکنیکهای تقویت داده (Data Augmentation) است. با استفاده از تکنیکهای تقویت داده، میتوانید تنوع بیشتری در دادههای آموزشی ایجاد کنید. این تکنیکها شامل چرخش، انتقال، بزرگنمایی، کوچکنمایی و تغییر شکل دادهها است. با اعمال این تغییرات، میتوانید تعداد نمونههای آموزشی را افزایش داده و بیشبرازش را کاهش دهید.

مثالی از بیش برازش

تصور کنید که شما یک مدل یادگیری ماشین برای تشخیص تصاویر گربه و سگ آموزش میدهید. شما ۱۰۰۰ تصویر از گربه و ۱۰۰۰ تصویر از سگ به عنوان دادههای آموزشی دارید. حالا فرض کنید مدل شما بسیار پیچیده است و توانایی بالایی در حفظ جزئیات تصاویر دارد. در فرآیند آموزش، مدل شما به طور کامل به دادههای آموزشی خود overfit میشود، به این معنی که به طور صحیح تمام تصاویر گربهها و سگهای آموزشی را تشخیص میدهد و دقت بالایی در آموزش دارد.

اما وقتی که شما مدل خود را با تصاویر جدیدی از گربه و سگ که قبلا دیده نشدهاند مواجه میکنید، شاید مدل شما نتواند به درستی تشخیص دهد. به عبارت دیگر، عملکرد مدل در دادههای تستی نسبت به دادههای آموزشی به طور قابل توجهی کاهش مییابد. این به دلیل این است که مدل شما به طور زیاد به جزئیات و نویزهای موجود در دادههای آموزشی وابسته شده است و قوانین عمومی را درک نمیکند. بنابراین، در اینجا overfitting رخ داده است. مدل به دادههای آموزشی خود بسنده کرده و قوانین عمومی را تشخیص نمیدهد. این مثال نشان میدهد که overfitting چگونه میتواند باعث کاهش عملکرد مدل در دادههای جدید شود.

چگونه بیش برازش را شناسایی کنیم؟

شناسایی بیشبرازش (Overfitting) میتواند از طریق بررسی و مقایسه عملکرد مدل بر روی دادههای آموزش و دادههای اعتبارسنجی یا آزمون انجام شود. راهکارهای مختلفی برای شناسایی بیشبرازش وجود دارد. اولین مورد مقایسه خطاها است. مقایسه خطاهای مدل بر روی دادههای آموزش و دادههای اعتبارسنجی یا آزمون میتواند به شناسایی بیشبرازش کمک کند. اگر خطای مدل بر روی دادههای آموزش به طور مداوم کاهش یابد، اما خطای مدل بر روی دادههای اعتبارسنجی یا آزمون شروع به افزایش کند، این ممکن است نشانهای از بیشبرازش باشد. مورد بعدی نمودار تابع هزینه است. با رسم نمودار تابع هزینه (loss function) در طول فرآیند آموزش، میتوانید تغییرات آن را بر روی دادههای آموزش و دادههای اعتبارسنجی مشاهده کنید. اگر تابع هزینه بر روی دادههای آموزش به طور مداوم کاهش یابد، اما بر روی دادههای اعتبارسنجی شروع به افزایش کند، این ممکن است نشانهای از بیشبرازش باشد. راهکار دیگر بررسی دقت مدل است. بررسی دقت مدل بر روی دادههای آموزش و دادههای اعتبارسنجی یا آزمون نیز میتواند به شناسایی بیشبرازش کمک کند. اگر دقت مدل بر روی دادههای آموزش به طور مداوم افزایش یابد، اما دقت بر روی دادههای اعتبارسنجی یا آزمون شروع به کاهش کند، این نشانهای از بیشبرازش است.

اگر از روشهای مانند ماشین بردار پشتیبان (SVM) استفاده میکنید، میتوانید کرنلهای خطا را بررسی کنید. اگر کرنل خطای مدل بر روی دادههای آموزش به طور مداوم کاهش یابد، اما بر روی دادههای اعتبارسنجی یا آزمون شروع به افزایش کند، این ممکن است نشانهای از بیشبرازش باشد. همانگونه که اشاره شد استفاده از اعتبارسنجی متقابل (Cross-validation) در شناسایی بیشبرازش کمک میکند. در این روش، دادهها را به چندین بخش تقسیم میکنیم و مدل را بر روی بخشهایی از دادهها آموزش میدهیم و سپس روی بخشهای دیگر مورد ارزیابی قرار میدهیم. اگر مدل بر روی دادههای آموزش عملکرد بسیار خوبی داشته باشد، اما بر روی دادههای آزمون عملکرد ضعیفتری داشته باشد، این نشانهای از بیشبرازش است.

به طور کلی، هرگاه مدل بر روی دادههای آموزشی به طور بیشازحد دقیق شود و توانایی خوبی در پیشبینی دادههای آموزشی داشته باشد، اما بر روی دادههای جدید یا آزمون عملکرد ضعیفی داشته باشد، میتوانید به وجود بیشبرازش مشکوک شوید. در این صورت، میتوانید اقداماتی مانند استفاده از تکنیکهایی مثل کاهش بعد، استفاده از تکنیکهای تنظیم پارامترها یا جمعآوری دادههای بیشتر را امتحان کنید تا بیشبرازش را کم کنید.

تفاوت بیش برازش (Overfitting) و کم برازش (Underfitting)

بیشبرازش (Overfitting) و کمبرازش (Underfitting) دو مشکل متفاوت در آموزش مدل هستند و به موارد زیر اشاره میکنند:

بیشبرازش (Overfitting):

در بیشبرازش، مدل به طور مداوم به دادههای آموزش خود متکی میشود و دقت روی دادههای آموزش بسیار بالا است. با این حال، عملکرد مدل روی دادههای جدید یا آزمون ضعیف است و دقت کاهش مییابد. بیشبرازش ممکن است به دلیل پیچیدگی زیاد مدل نسبت به حجم کم دادههای آموزش، عدم تعادل میان دادههای آموزش و دادههای آزمون، یا عدم استفاده مناسب از تکنیکهای مقابله با بیشبرازش ایجاد شود. در بیشبرازش، ممکن است مدل جزییات نویزهای موجود در دادههای آموزش را فراگیرد و این میتواند باعث کاهش عمومیت و قابلیت اعتبارسنجی مدل بر روی دادههای جدید شود.

کمبرازش (Underfitting):

در کمبرازش، مدل توانایی کافی برای یادگیری الگوهای موجود در دادههای آموزش را ندارد و دقت روی دادههای آموزش و دادههای آزمون هر دو پایین است. این مشکل ممکن است به دلیل سادگی بیش از حد مدل نسبت به پیچیدگی دادهها، کمبود دادههای آموزش، یا عدم استفاده مناسب از تکنیکهای برازش ایجاد شود. در کمبرازش، مدل نتوانسته است الگوهای موجود در دادهها را به خوبی یاد بگیرد و توانایی کمی در زمینه پیشبینی دادههای جدید دارد.

برای رفع بیشبرازش، میتوان از روشهایی مانند استفاده از تکنیکهای رگولاریزاسیون، کاهش بعد، تکنیکهای تنظیم پارامترها و جمعآوری دادههای بیشتر استفاده کرد. در مورد کمبرازش، میتوان با افزایش پیچیدگی مدل، استفاده از الگوریتمهای آموزش پیشرفته یا جمعآوری دادههای بیشتر مشکل را بررسی و رفع کرد.

مهندسی ویژگی

مهندسی ویژگی (Feature Engineering) یک مرحله مهم و اساسی در فرایند تحلیل داده و ساخت مدلهای یادگیری ماشین است. در این مرحله، ویژگیهای مورد استفاده برای توصیف دادهها انتخاب و تبدیل میشوند تا بتوانند به خوبی توسط مدلهای یادگیری ماشین فهمیده شوند و الگوهای موجود در دادهها را تشخیص دهند. مهندسی ویژگی به دست آوردن ویژگیهای مناسب و معنادار از دادهها را شامل میشود. برخی از فعالیتهای مرسوم در مهندسی ویژگی عبارتند از:

انتخاب ویژگی (Feature Selection): انتخاب ویژگیهای مهم و مفید از مجموعه ویژگیهای موجود. این فعالیت به کاهش پیچیدگی مدل و بهبود عملکرد آن کمک میکند.

استخراج ویژگی (Feature Extraction): تبدیل دادههای اولیه به ویژگیهای جدید و معنادار. میتوان از تکنیکهای مانند تحلیل مولفههای اصلی (PCA)، تجزیه ماتریس فاکتوری (Factorization Matrix Decomposition) و تحلیل خوشهبندی (Clustering) استفاده کرد.

تبدیل ویژگی (Feature Transformation): تبدیل ویژگیها به صورتی که بهترین عملکرد را برای مدلهای یادگیری ماشین داشته باشند. به عنوان مثال، مقیاسبندی ویژگیها (Scaling)، کدگذاری برچسب (Label Encoding) و تبدیل ویژگیهای غیرخطی (Non-linear Feature Transformation) از جمله روشهای مورد استفاده در این فعالیت هستند.

ساخت ویژگی جدید (Feature Creation): ساخت ویژگیهای جدید بر اساس دانش موضوعی در مورد دادهها و مساله. این فعالیت میتواند شامل ترکیب ویژگیهای موجود، استفاده از توابع ریاضی، ایجاد ویژگیهای ترتیبی و غیره باشد.

مهندسی ویژگی اغلب به تجربه و دانش موضوعی نیاز دارد و ممکن است بر اساس مساله و دادههای مورد نظر تغییر کند. با استفاده از مهندسی ویژگی بهینه، میتوان اطلاعات بیشتری از دادهها استخراج کرده و بهبودی در عملکرد مدلههای یادگیری ماشین ایجاد کرد.

توقف زودهنگام

توقف زودهنگام (Early stopping) یک روش مقابله با بیشبرازش در آموزش مدلهای یادگیری ماشین است. در این روش، فرایند آموزش مدل در هر مرحله مورد ارزیابی قرار میگیرد و اگر عملکرد مدل روی دادههای اعتبارسنجی (Validation) بهبودی نداشته باشد، آموزش متوقف میشود. عملکرد مدل روی دادههای اعتبارسنجی به طور معمول با استفاده از معیارهای ارزیابی مانند دقت (accuracy)، خطا (error) یا هر معیار مرتبط دیگر اندازهگیری میشود. در حین آموزش مدل، معیار ارزیابی روی دادههای اعتبارسنجی پس از هر دوره (epoch) محاسبه میشود. اگر مشاهده شود که عملکرد مدل بر روی دادههای اعتبارسنجی بهبود نمییابد یا شروع به کاهش میکند، مدل متوقف و به عنوان مدل نهایی انتخاب میشود. استفاده از توقف زودهنگام دارای مزایا و محدودیتهایی است. اولین مورد جلوگیری از بیشبرازش است. با توقف زودهنگام، مدل قبل از رسیدن به بیشبرازش متوقف میشود که منجر به عملکرد بهتر بر روی دادههای آزمون میشود. مورد بعد صرفهجویی در زمان و منابع است.

با توقف زودهنگام، میتوان زمان و منابع زیادی که برای آموزش بیشبرازشی صرف میشود را صرف آموزش یک مدل بهتر کرد. مورد بعد سادهسازی فرایند انتخاب مدل است. با توقف زودهنگام، نیازی به انتخاب یک مدل نهایی از بین چندین مدل مختلف نیست، زیرا مدلی که در زمان توقف انتخاب میشود، به عنوان مدل نهایی استفاده میشود. اما همانگونه که اشاره کردیم، روش فوق محدودیتهایی نیز دارد. اولین مورد احتمال از دست دادن بهترین مدل است. در برخی موارد، با توقف زودهنگام، ممکن است بهترین مدل که بعد از توقف میتوانست بهبود یابد را از دست داده باشیم. مورد بعد در ارتباط با وابستگی به انتخاب صحیح نقطه توقف است. انتخاب نقطه توقف مناسب در فرایند آموزش مدل میتواند چالشهایی داشته باشد و نیاز به آزمون و خطا دارد. به طور کلی، توقف زودهنگام یک روش مفید است که باعث جلوگیری از بیشبرازش و بهبود عملکرد مدلهای یادگیری ماشین میشود. با این حال، باید به شکل دقیق از آن استفاده کرد.

انتخاب ابرپارامترها

انتخاب ابرپارامترها (Hyperparameter Tuning) یک فرآیند مهم در آموزش مدلهای یادگیری ماشین است. ابرپارامترها، پارامترهایی هستند که قبل از آموزش مدل تعیین میشوند و تاثیر مستقیم بر عملکرد مدل دارند. مثالهایی از ابرپارامترها شامل تعداد لایهها و نورونها در شبکه عصبی، ضریب یادگیری (learning rate) در الگوریتمهای گرادیان کاهشی و تعداد درختها در روشهای درخت تصمیم (Decision Tree) است. برخلاف پارامترهای مدل که به طور خودکار توسط الگوریتمهای یادگیری ماشین تنظیم میشوند، ابرپارامترها باید توسط کاربر تنظیم شوند. اما انتخاب درست ابرپارامترها به طور معمول یک فرایند مشکل و زمانبر است و نیاز به آزمون و خطا دارد. برای انتخاب ابرپارامترها، میتوانید از روشهای زیر استفاده کنید:

جستجوی شبکهای: در این روش، یک مجموعه از مقادیر ممکن برای هر ابرپارامتر تعیین میشود و سپس مدل با استفاده از هر ترکیب ممکن از این مقادیر آموزش داده میشود. سپس عملکرد مدل بر روی دادههای اعتبارسنجی ارزیابی میشود و مقادیر بهترین ابرپارامترها انتخاب میشوند.

جستوجوی تصادفی: در این روش، مقادیر تصادفی برای ابرپارامترها انتخاب میشوند و مدل با استفاده از این ترکیبها آموزش داده میشود. سپس عملکرد مدل ارزیابی میشود و ترکیبی که بهترین عملکرد را داشته باشد انتخاب میشود.

بهینهسازی خودکار: میتوانید از روشهای خودکاری مانند جستوجوی شبکه (Grid Search) یا جستوجوی تصادفی (Randomized Search) استفاده کنید. این روشها مقادیر ابرپارامترها را با ترکیبهای مختلف از مقادیر تعیین شده تنظیم میکنند و بهترین ترکیب را انتخاب میکنند.

استفاده از الگوریتمهای هوشمند: میتوانید از الگوریتمهای بهینهسازی مانند جستوجوی خودکار تعدادی از الگوریتمهای هوشمند مانند الگوریتم ژنتیک (Genetic Algorithm)، الگوریتم تطبیقی ذرات (Particle Swarm Optimization) و تجزیه و تحلیل شبکه عصبی (Neural Architecture Search) استفاده کنید. این الگوریتمها میتوانند به صورت خودکار و همزمان ابرپارامترها را بهینه کنند.

در نهایت، برای انتخاب ابرپارامترها باید توجه کنید که عملکرد مدل روی دادههای اعتبارسنجی معتبر است و نه روی دادههای آموزشی. همچنین، ممکن است نیاز به ترکیب چندین روش و تکنیک برای بهینهسازی ابرپارامترها باشد. در نهایت، با تجربه و تحلیل دقیق، میتوانید بهترین ترکیب ابرپارامترها را برای مدل خود انتخاب کنید.

اضافه کردن داده های آموزشی

اضافه کردن دادههای آموزشی به مجموعه دادهها یکی دیگر از راهکارها برای غلبه بر مشکل بیشبردازش است. این راهکار به روشهای مختلفی قابل انجام است. اولین مورد اضافه کردن دادهها به شیوه دستی است. این روش شامل ایجاد دادههای جدید و اضافه کردن آنها به مجموعه داده آموزشی است. این کار میتواند با تکرار و یا تغییر تصاویر، ترکیب دادههای موجود یا افزودن نمونههای جدید با برچسبهای مختلف انجام شود. راهکار بعدی استفاده از تکنیکهای تولید داده (Data Augmentation) است. با استفاده از تکنیکهای تولید داده میتوانید دادههای جدیدی را از دادههای موجود بسازید. این تکنیکها شامل تغییر اندازه، چرخش، تغییر روشنایی، اعمال نویز و … میشوند. با این روش، میتوانید حجم دادههای آموزشی خود را بدون نیاز به جمعآوری داده جدید افزایش دهید. راهکار دیگر استفاده از دادههای عمومی (Public Datasets) است. میتوانید از مجموعه دادههای عمومی که برای پژوهشهای علمی وجود دارند استفاده کنید. این دادهها معمولا با برچسبهای موجود هستند و میتوانید آنها را به مجموعه داده آموزشی خود اضافه کنید.

میتوانید از دادههایی که توسط مدلهای دیگر تولید شدهاند استفاده کنید. برای مثال، میتوانید از دادههای تولید شده توسط شبکههای مولد مقابلهای (GANs) استفاده کنید و آنها را به مجموعه داده آموزشی خود اضافه کنید. در هر صورت، قبل از اضافه کردن دادههای جدید به مجموعه آموزشی، باید مطمئن شوید که دادههای جدید موثر و مناسب برای مسئله هستند و تناسبی میان دادههای جدید و دادههای مجموعه آموزشی وجود دارد. همچنین، باید به نسبت دادههای آموزشی و دادههای اعتبارسنجی توجه کنید تا مدل به درستی آموزش ببیند و عملکردش بهبود پیدا کند.

یادگیری جمعی

یادگیری جمعی (Ensemble Learning) یکی دیگر از روشهای قدرتمند در این زمینه است که بر پایه ترکیب پیشبینیهای مختلف از چندین مدل مستقل برای بهبود کارایی و قدرت تخمین استفاده میشود. در این روش، چندین مدل (معمولا با الگوریتمهای یادگیری متفاوت) آموزش داده میشوند و سپس پیشبینیهای هر یک از آنها ترکیب میشوند تا به یک پیشبینی نهایی برسیم. مزیت اصلی استفاده از یادگیری جمعی این است که میتواند بهبود قابل توجهی در عملکرد پیشبینیها داشته باشد. در واقع، با ترکیب پیشبینیهای مختلف، ممکن است نقاط ضعف یک مدل خاص کاهش یابد و قدرت تخمین بهبود یابد. همچنین، یادگیری جمعی میتواند مقاومت بیشتری در برابر برهمکنش و پدیدههای ناخواسته داشته باشد. روشهای مختلفی برای استفاده از تکنیک فوق به شرح زیر وجود دارد.

رایگیری (Voting): در این روش، پیشبینیهای مختلف مدلها بر اساس رای اکثریت ترکیب میشوند. میتواند به صورت رای اکثریت ساده یا با وزندهی به پیشبینیها انجام شود.

بوستینگ (Boosting): در این روش، مدلها به ترتیب ساخته میشوند و هر مدل سعی میکند بر روی نمونههایی که توسط مدلهای قبلی اشتباه تشخیص داده شدهاند تمرکز کند. این روش معمولا با استفاده از الگوریتمهایی مانند AdaBoost و Gradient Boosting انجام میشود.

Bagging: در این روش، مدلها با استفاده از زیرمجموعههای تصادفی از دادههای آموزشی تولید میشوند و سپس پیشبینیها ترکیب میشوند. این روش عمدتا با استفاده از جنگل تصادفی (Random Forest) انجام میشود.

مزیت دیگر یادگیری جمعی این است که میتواند از انواع مدلها و الگوریتمهای یادگیری مختلف استفاده کند و بهترین ترکیب را بر اساس مسئله موردی بررسی کند. همچنین، با استفاده از یادگیری جمعی میتوانید اطمینان بیشتری از پایداری و قابلیت انتقال مدل خود داشته باشید، زیرا ترکیب پیشبینیهای مدلهای مستقل میتواند اثر تغییرات دادهها را کاهش دهد.

روشهای منظم سازی

روشهای منظم سازی در یادگیری ماشین، روشهایی هستند که برای کاهش برازش بیشبرازش (Overfitting) و بهبود عملکرد مدل در دادههای جدید استفاده میشوند. این روشها به منظور کنترل پیچیدگی مدل، جلوگیری از بیشبرازش و ایجاد تعمیمپذیری بهتر مدل استفاده میشوند. یکی از روشهای منظمسازی معروف، استفاده از جریمهکردن است. در این روش، یک جریمه اضافی به تابع هدف اضافه میشود که معمولا بر اساس پارامترهای مدل و وزنها محاسبه میشود. دو نوع جریمه رایج وجود دارد. جریمه (L1 Regularization) یا جریمه مقدار مطلق که مقدار مطلق وزنها به تابع هدف اضافه میشود. این روش میتواند باعث کاهش وزنهای غیرضروری شود و ویژگیهای مهم را برجسته کند. دومین مورد جریمه (L2 Regularization) یا جریمه مربعات است. در این روش، مقدار مربعات وزنها به تابع هدف اضافه میشود. رویکرد فوق باعث کاهش تفاوت بین وزنها میشود و میتواند به پایداری مدل کمک کند.

این روشها تنها چند نمونه از روشهای منظمسازی در یادگیری ماشین هستند. انتخاب روش مناسب بستگی به مساله مورد نظر، نوع دادهها و الگوریتمهای استفاده شده دارد. استفاده از روشهای منظمسازی مناسب میتواند بهبود قابل توجهی در عملکرد مدلهای یادروشهای منظمسازی در یادگیری ماشین مورد استفاده قرار میگیرند تا بیشبرازش (overfitting) و کمبرازش (underfitting) مدلها را کاهش دهد و عملکرد آنها را بهبود بخشد.

بخوانید: جیتر (Jitter) در شبکه به چه معناست ؟

بدون دیدگاه