یادگیری تقویتی

زمان تخمینی مطالعه: 18 دقیقه

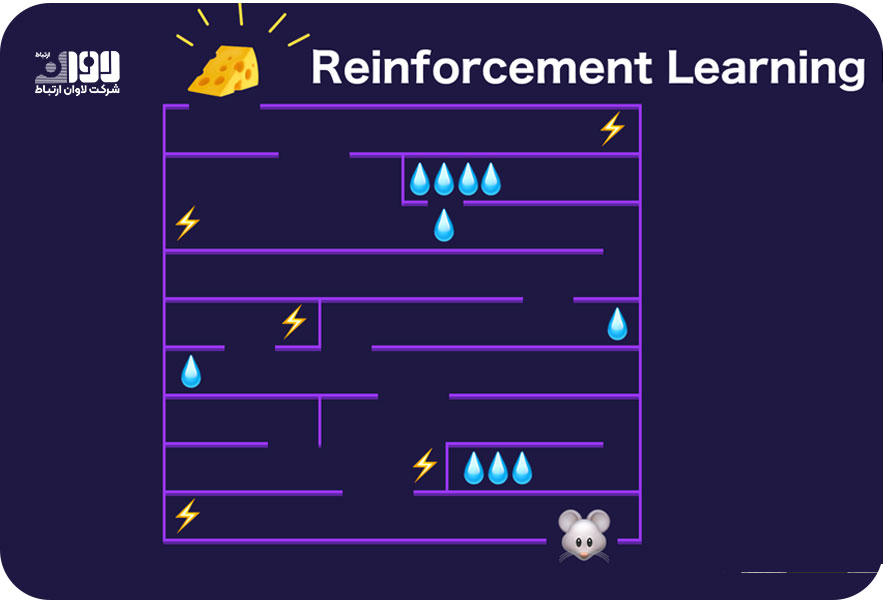

یادگیری تقویتی (Reinforcement Learning) یکی از الگوهای اصلی یادگیری ماشین است که بر پایه تعامل مکرر یک عامل با یک محیط برنامهریزی میشود. در این روش، عامل (agent) با توجه به وضعیت فعلی محیط و بر اساس تجربیاتی که یاد گرفته است، عملی را انتخاب کرده و انجام میدهد. سپس، عمل انتخاب شده توسط عامل به محیط اعمال میشود و محیط بازخوردی (reward) به عامل میدهد. هدف عامل در یادگیری تقویتی، بهبود سیاستهای خود است، بهطوری که مجموع پاداشهای دریافتی در طول زمان بیشینه شود.

عامل در یادگیری تقویتی بدون داشتن دستههای دقیق برچسبگذاری شده برای ورودیها، فقط از طریق تجربه و تعامل با محیط، تجارب جدید را میآمزود. این روش بر پایه مفهوم تقویتی (reinforcement) بوده و عامل با انجام عملی خوب و دریافت پاداش، تشویق به انجام عملی مشابه در آینده میشود. به همین دلیل، یادگیری تقویتی را گاهی اوقات یادگیری بدون نظارت تقویت شده نیز مینامند. یادگیری تقویتی در مواردی کاربرد دارد که عامل باید در محیطی پویا و تعاملی اقدامات خود را برنامهریزی کند و با محیط هماهنگ شود. از کاربردهای این پارادایم باید به بازیهای رایانهای، رباتیک، مدیریت منابع، بهینهسازی مسائل پیچیده، مدیریت ترافیک و سیستمهای توزیع شده اشاره کرد.

فرآیند یادگیری تقویتی

فرآیند یادگیری تقویتی در اصل شامل چند مرحله است که عامل در طی آنها با محیط تعامل میکند و سیاستهای بهتر را یاد میگیرد. این مراحل به شرح زیر هستند:

- تعریف مساله: در این مرحله، مساله مورد نظر برای یادگیری تقویتی مشخص میشود که شامل تعریف وضعیتها، عملها، پاداشها و ساختار کلی محیط است. علاوه بر این، هدف کلی یادگیری نیز تعیین میشود. به بیان دقیقتر، در یادگیری تقویتی، تعریف مساله به منظور مشخص کردن محیط و هدف یادگیری عامل انجام میشود. این مرحله برای تعیین مسیر و راهحلهای بهینه در فرآیند یادگیری بسیار حایز اهمیت است. به طور کلی، تعریف مساله در یادگیری تقویتی به منظور تعیین وضعیتها، عملها، پاداشها و سیاستها انجام میشود. این تعریف مساله اساسی است که روشها و الگوریتمهای یادگیری تقویتی بر اساس آن طراحی میشوند تا عامل بتواند سیاستهای بهینه را یاد بگیرد و عملکرد خود را بهبود بخشد.

- تعریف وضعیتها و عملها

در این مرحله، وضعیتها و عملها در محیط مورد بررسی شناسایی میشوند. وضعیتها ممکن است شامل اطلاعات مشاهده شده از محیط یا وضعیت داخلی عامل باشند. عملها نیز مجموعهای از اقدامات قابل انجام توسط عامل هستند. توضیحات کلی درباره تعریف وضعیتها و عملها در یادگیری تقویتی به شرح زیر است:

تعریف وضعیتها: وضعیتها نشاندهنده شرایط محیطی هستند که عامل در آن قرار میگیرد. وضعیتها میتوانند اطلاعات مشاهده شده از محیط و یا وضعیت داخلی عامل را شامل شوند. به طور کلی، وضعیتها میتوانند به صورت توصیفی (مشاهده شده) یا به صورت خلاصه (توصیفی) تعریف شوند. برای مثال، در یک بازی شطرنج، وضعیت میتواند شامل موقعیت مهرهها در صفحه شطرنج، نوبت بازیکن و سایر جزییات بازی باشد.

تعریف عملها: عملها نشاندهنده اقدامات قابل انجام توسط عامل در هر وضعیت هستند. معمولا عملها در قالب یک فضای عمل تعریف میشوند. فضای عمل میتواند متناهی یا نامتناهی باشد و شامل تمام عملهای مجاز در محیط است. برای مثال، در یک بازی شطرنج، عملها میتوانند شامل حرکت مهرهها، قرار دادن پیشبینیها یا انجام تغییرات دیگر در صفحه بازی باشند.

تعریف وضعیتها و عملها بسته به مساله و محیط مورد نظر ممکن است متفاوت باشد و بر اساس ویژگیها و قیدهای مربوطه تعیین شود. در برخی موارد، ممکن است از تکنیکهایی مانند تابعهای شناسایی وضعیت (State Identification Functions) و تابعهای شناسایی عمل (Action Identification Functions) استفاده شود تا وضعیتها و عملها به صورت خاص تعریف شوند و یا تعریف وضعیتها و عملها مستقیما بر اساس دادههای مشاهده شده انجام شود.

- تعریف پاداش

در این مرحله، نحوه ارزیابی عملها توسط محیط و تعریف پاداشها مشخص میشود. پاداشها معمولا به صورت عددی تعریف میشوند و نشان میدهند که عملی چقدر مطلوب است. هدف عامل در یادگیری تقویتی این است که مجموع پاداشهای دریافتی را بیشینه کند. همانگونه که اشاره کردیم، پاداشها معمولا توسط محیط به عامل ارائه میشوند و عامل باید با تجربه و تعامل با محیط، سیاستهای مناسبی را یاد بگیرد تا بتواند پاداشهای بیشتری دریافت کند.

در برخی موارد، پاداشها میتوانند به صورت فوریتی (Immediate Reward) تعریف شوند که به میزان پاداش دریافتی توسط عامل بلافاصله پس از انجام عمل در وضعیت مشخص اشاره دارند. به عنوان مثال، در یک بازی کامپیوتری، پاداش فوری میتواند امتیازی باشد که عامل بلافاصله بعد از انجام حرکتی دریافت میکند. علاوه بر پاداشهای فوری، ممکن است پاداشهای تاخیری (Delayed Reward) نیز در نظر گرفته شوند. پاداشهای تاخیری به میزان پاداش دریافتی توسط عامل در طول زمان و به دلیل انجام عملهای متوالی در وضعیتهای مختلف اشاره دارند. به عنوان مثال، در یک بازی استراتژیک، پاداش تاخیری میتواند امتیازی باشد که عامل پس از گذشت چند مرحله از بازی دریافت میکند. تعریف پاداش در یادگیری تقویتی معمولا به تفصیل صورت نمیگیرد و محتوا و مقدار پاداشها بسته به مساله و برنامهریزی خاص یادگیری تقویتی متفاوت است. در برخی موارد، از توابع ارزیابی پاداش (Reward Shaping Functions) نیز استفاده میشود تا پاداشهای اصلی را با پاداشهای فرعی یا تعدیلشده بهبود داده و فرآیند یادگیری را تسریع کرد.

- تعریف سیاست

سیاستها در یادگیری تقویتی نشاندهنده نحوه تصمیمگیری عامل بر اساس وضعیتهای مشاهده شده است. سیاست میتواند به صورت قوانین (قواعد تصمیمگیری) یا به صورت تابع (تابع ارزش یا تابع عمل) تعریف شود. هدف عامل در این مرحله یادگیری سیاست بهینه است که مجموع پاداشها را بیشینه کند. در یادگیری تقویتی، سیاست (Policy) به عنوان یک تابع تصمیمگیری تعریف میشود که نحوه عملکرد عامل در محیط را مشخص میکند. سیاست نشان میدهد که در هر وضعیت، عامل چه عملی را باید انتخاب کند. به طور سادهتر، سیاست مشخص میکند که عامل در وضعیتهای مختلف چه کاری انجام دهد. سیاست میتواند به صورت تابعی مستقل از زمان (Time-Independent)، که به عنوان یک تابع ثابت عمل میکند یا به صورت تابعی وابسته به زمان (Time-Dependent) که میتواند تغییر کند، تعریف شود. در سیاست مستقل از زمان، عامل همیشه با توجه به وضعیت فعلی به یک عمل خاص تصمیم میگیرد، اما در سیاست وابسته به زمان، عامل ممکن است توسط تجربههای قبلی خود و یا با توجه به تغییرات محیط، سیاست خود را تغییر دهد.

سیاست میتواند به صورت قاعدهمند (Deterministic) یا به صورت تصادفی (Stochastic) تعریف شود. در سیاست قاعدهمند، در هر وضعیت، عامل همیشه یک عمل خاص را انتخاب میکند. اما در سیاست تصادفی، عامل با احتمالات مشخصی بین چند عمل ممکن تصمیم میگیرد. سیاست میتواند به صورت ثابت (Static) تعریف شود که در آن عامل در هر وضعیت یک سیاست ثابت را دنبال میکند، یا به صورت دینامیک (Dynamic) که در آن عامل در طول زمان میتواند سیاست خود را تغییر دهد.

تعریف سیاست معمولا بر اساس تجربههای عامل و هدف یادگیری تقویتی تعیین میشود. هدف اصلی در یادگیری تقویتی بهینهسازی سیاست است تا عامل بتواند پاداش بیشتری دریافت کند و عملکرد بهتری در محیط داشته باشد.

- تعامل با محیط

در این مرحله، عامل با محیط تعامل میکند و بر اساس سیاستهای خود عملهایی را انجام میدهد. هنگام انجام هر عمل، محیط پاداشی به عامل میدهد که نشاندهنده عمل مورد انتظار است. عامل بر اساس این بازخورد، سیاستها و روشهای یادگیری خود را بهبود میبخشد. تعامل با محیط در یادگیری تقویتی به صورت تعاملی و دوسویه بین عامل و محیط انجام میشود. در هر مرحله از فرآیند یادگیری، عامل با محیط تعامل میکند تا وضعیت فعلی را مشاهده کند، عملی را انجام دهد و پاداش مربوط به آن عمل را دریافت کند. این تعامل پیوسته در طول زمان ادامه مییابد تا عامل بتواند بر اساس تجربههای خود عملکرد خود را بهبود بخشد. فرآیند تعامل با محیط در یادگیری تقویتی عموما به صورت زیر پیش میرود:

عامل وضعیت محیط را مشاهده میکند: در هر مرحله، عامل اطلاعات مشاهده شده از محیط را دریافت میکند که شامل جزییات وضعیت فعلی محیط و اطلاعات دیگری که ممکن است در تعیین عمل بعدی تاثیرگذار باشند، میشود.

عامل عمل را انتخاب میکند: بر اساس وضعیت فعلی، عامل بر اساس سیاست خود یک عمل خاص را انتخاب میکند. سیاست مشخص میکند که در هر وضعیت، عامل باید چه عملی را انجام دهد.

اجرای عمل توسط عامل در محیط: عامل عمل انتخاب شده را در محیط اجرا میکند. این عمل ممکن است تغییراتی در محیط ایجاد کند.

عامل پاداش را دریافت میکند: بعد از اعمال عمل، عامل پاداش مربوط به عمل انجام شده را از محیط دریافت میکند. پاداش میتواند از خود محیط دریافت شود و یا به عنوان ورودی به عامل داده شود.

وضعیت جدید را مشاهده میکند: پس از دریافت پاداش، عامل وضعیت جدید محیط را مشاهده میکند که نتیجه عمل انجام شده و تغییراتی که در محیط ایجاد شده است را نشان میدهد.

- یادگیری و بهبود سیاست

در این مرحله، عامل بر مبنای امتیازاتی که دریافت کرده است، اشتباهات قبلی را برطرف میکند تا بتواند عملکرد دقیقتری از خود نشان دهد. دو روش مهم برای یادگیری و بهبود سیاست به شرح زیر است:

روش مستقیم: در این روش، عامل مستقیما سیاست خود را بر اساس تجربه بهبود میدهد. یعنی عامل با توجه به پاداشهای دریافتی از محیط، سعی میکند سیاست خود را به گونهای تغییر دهد که پاداش کلی حاصله بیشتر شود. این روش به صورت معمول با استفاده از الگوریتمهایی مانند الگوریتمهای Gradient Ascent، Policy Gradient و REINFORCE انجام میشود. در روش مستقیم، عامل پارامترهای سیاست خود را به صورت مستقیم به روزرسانی میکند. به این ترتیب، با تکرار تعامل با محیط و بهروزرسانی سیاست، سیاست بهتری یاد میگیرد که منجر به عملکرد بهتر در محیط میشود.

روش غیرمستقیم: در این روش، عامل از تابع ارزش یا تابع عملکرد (value function) استفاده میکند تا سیاست خود را بهبود بخشد. تابع ارزش، تخمینی از ارزش هر وضعیت یا جفت وضعیت-عمل در محیط است و نشان میدهد که وضعیت یا جفت وضعیت-عمل چقدر ارزش دارد. عامل با استفاده از این تخمین، سعی میکند عملی را انتخاب کند که ارزش کلی را بیشینه کند. روشهای غیرمستقیم شامل الگوریتمهایی مانند Q-Learning، SARSA و Deep Q-Networks (DQN) هستند. این الگوریتمها با استفاده از تابع ارزش، تخمینی از بهترین عمل در هر وضعیت را محاسبه کرده و بر اساس آن، سیاست خود را بهبود میدهند. در روش غیرمستقیم، عامل ابتدا تخمینی از تابع ارزش را به دست میآورد و سپس بر اساس این تخمین، سیاست خود را بهبود میبخشد. این روش به صورت پیشبینی-ارزشگذاری (value-based) عمل میکند و به عامل امکان میدهد تا ارزش هر وضعیت را تخمین بزند.

همچنین، روشهایی مانند Actor-Critic و Proximal Policy Optimization (PPO) که ترکیبی از روشهای مستقیم و غیرمستقیم هستند، نیز برای یادگیری و بهبود سیاست در یادگیری تقویتی استفاده میشوند. این الگوریتمها همزمان تلاش میکنند تا سیاست را بهبود بخشند و تابع ارزش را بهینه کنند.

در کل، یادگیری و بهبود سیاست در یادگیری تقویتی به وسیله تعامل با محیط، تجربه از پاداشهای دریافتی و استفاده از الگوریتمهای مناسب برای بهبود سیاست، انجام میشود. هدف این فرآیند، یافتن سیاستی است که عامل را به عملکرد بهتر و بهبود پاداش کلی هدایت کند.

تفاوت یادگیری تقویتی با سایر روش های یادگیری ماشین

یادگیری تقویتی از سایر روشهای یادگیری ماشین متمایز است و تقریبا یک سطح بالاتری از پارادایمهای دیگر این حوزه است. برخی از تفاوتهای اصلی یادگیری تقویتی با روشهای دیگر به شرح زیر است:

تعامل با محیط: یادگیری تقویتی بر پایه تعامل مستقیم و پویا با محیط است. عامل در یادگیری تقویتی برخلاف روشهای دیگر، اطلاعات را به صورت تجربی از محیط دریافت میکند و براساس آن تصمیمگیری میکند. این تعامل مستمر با محیط و اثرگذار بر روی آن، مهمترین ویژگی یادگیری تقویتی است.

پاداش و تاخیر: در یادگیری تقویتی، عامل از طریق تعامل با محیط پاداشها را دریافت میکند. پاداشها معیاری هستند که نشان میدهند که عملکرد عامل در محیط چقدر مطلوب است. هدف عامل در یادگیری تقویتی، انتخاب عملهایی است که باعث بیشینه کردن پاداش کلی در طول زمان میشوند. علاوه بر پاداش، تاخیر (delay) نیز در یادگیری تقویتی مهم است، زیرا نتایج عملها ممکن است به طور مستقیم در آینده ظاهر شود و عامل باید بتواند تاخیرها را در نظر بگیرد و تصمیمگیری کند.

برهمکنش بین عامل و محیط: در یادگیری تقویتی، عامل و محیط به صورت یکپارچه و همزمان با یکدیگر عمل میکنند. عامل با انجام عملهای خود، محیط را تغییر میدهد و محیط نتیجه این تغییر را به عامل بازمیگرداند. این برهمکنش بین عامل و محیط، باعث میشود که یادگیری تقویتی با توجه به تغییرات محیط و پاداشهای دریافتی، سیاست خود را بهبود بخشد.

عدم نیاز به دادههای برچسبدار: در بسیاری از روشهای یادگیری ماشین مانند یادگیری نظارت شده، نیازمند دادههای برچسبدار هستیم تا مدل را آموزش دهیم. اما در یادگیری تقویتی، عامل بدون نیاز به دادههای برچسبدار میتواند از طریق تعامل با محیط خود را آموزش دهد.

مفهوم تاخیر زمانی: در یادگیری تقویتی، مفهوم تاخیر زمانی (temporal delay) مهم است. تاخیر زمانی به این معنی است که عملی که عامل انجام میدهد، ممکن است تاثیر خود را در آینده نشان دهد و عامل باید بتواند تاخیر زمانی را در نظر بگیرد و رابطهای میان عمل و پاداش در طول زمان بسازد. این تفاوت اصلی یادگیری تقویتی با یادگیری نظارت شده و بدو ناظر است.

مفهوم موجودیت و بیشینهکردن پاداش کلی: هدف یادگیری تقویتی این است که عامل بتواند سیاست بهینه را یاد بگیرد که منجر به بیشینه کردن پاداش کلی (cumulative reward) در طول زمان میشود. در حالی که در روشهای دیگری مانند یادگیری نظارت شده، هدف این است که مدل بتواند به درستی برچسبها را پیشبینی کند یا در یادگیری تشخیصی، دستهبندیها را به دقت تشخیص دهد.

در کل، یادگیری تقویتی با استفاده از تعامل مستقیم با محیط و براساس مفهوم پاداش و تاخیر زمانی، عامل را آموزش میدهد تا بهترین سیاست را در محیط مشخص کند. در مقابل، روشهای دیگر یادگیری ماشین معمولا بر پایه دادههای برچسبدار یا تعامل کمتر با محیط عمل میکنند.

کاربردهای Reinforcement Learning

یادگیری تقویتی در موارد مختلفی مورد استفاده قرار میگیرد و در زمینههای گوناگون کاربردهای متنوعی دارد. برخی از کاربردهای مهم یادگیری تقویتی به شرح زیر است:

- رباتیک: یکی از کاربردهای اصلی یادگیری تقویتی در رباتیک است. عاملهای یادگیری تقویتی میتوانند به رباتها یاد بدهند که برای انجام وظایف خاصی، مانند حرکت، ناوبری، گرفتن و قرار دادن اشیا و غیره، چگونه عمل کنند. با تجربه و تعامل مستمر با محیط، رباتها میتوانند سیاستهای بهینه را یاد بگیرند و عملکرد خود را بهبود بخشند.

- بازیهای رایانهای: یادگیری تقویتی در بازیهای رایانهای ویدیویی نیز کاربردهای مهمی دارد. عاملهای یادگیری تقویتی میتوانند با تجربه و تعامل با بازی، استراتژیهای بهتری برای حل بازیها یاد بگیرند. این کاربرد در ایجاد عاملهای هوشمند در بازیهای رایانهای و همچنین در توسعه الگوریتمهای هوش مصنوعی قابل استفاده برای کاراکترهای بازی استفاده میشوند.

- مدیریت منابع و سیستمهای مخابراتی: یادگیری تقویتی میتواند در بهینهسازی مصرف منابع و مدیریت سیستمهای مخابراتی مورد استفاده قرار گیرد. با استفاده از الگوریتمهای یادگیری تقویتی، میتوان سیستمهایی را طراحی کرد که به صورت خودکار و بهینه، منابع را تخصیص دهند و عملکرد سیستم را بهبود بخشند.

- مدیریت مالی: یادگیری تقویتی در حوزه مدیریت مالی نیز کاربردهای مهمی دارد. میتوان از الگوریتمهای یادگیری تقویتی برای اتخاذ تصمیمات سرمایهگذاری، مدیریت ریسک، پیشبینی نرخ ارز و سایر مسایل مالی استفاده کرد. عاملهای یادگیری تقویتی میتوانند براساس دادههای بازار و تجربه قبلی، سیاستهای بهینه را برای مدیریت مالی تعیین کنند.

- بهینهسازی مصرف انرژی: یادگیری تقویتی میتواند در بهینهسازی مصرف منابع انرژی مورد استفاده قرار گیرد. با استفاده از الگوریتمهای یادگیری تقویتی، میتوان سیستمهایی را طراحی کرد که به صورت هوشمند و بهینه، منابع انرژی را مدیریت کنند. مثلا در شبکههای برق هوشمند، عاملهای یادگیری تقویتی میتوانند بر اساس نیازها و الگوهای مصرف، تصمیمات درستی را اتخاد کنند تا مصرف انرژی به حداقل برسد.

- سیستمهای مدیریت ترافیک: یادگیری تقویتی میتواند در بهینهسازی سیستمهای مدیریت ترافیک و راهبری شهری مورد استفاده قرار گیرد. با استفاده از الگوریتمهای یادگیری تقویتی، میتوان سیستمهایی را طراحی کرد که با تجمیع دادههای ترافیک، بهترین سیاستها را برای کنترل ترافیک ارائه دهند و بهبود عملکرد در شبکههای ترانزیت را به ارمغان آورند.

- بهبود عملکرد سیستمهای خودکار: یادگیری تقویتی میتواند در بهبود عملکرد سیستمهای خودکار مورد استفاده قرار گیرد. عاملهای یادگیری تقویتی میتوانند با تجربه و تعامل با محیط، خود را بهبود دهند و سیاستهای بهینه را برای اجرای وظایف خود یاد بگیرند. این کاربرد در سیستمهای خودران، سیستمهای هوشمند خانگی، رباتها و سایر سیستمهای خودکار قابل استفاده است.

موارد یاد شده تنها چند نمونه از کاربردهای مهم یادگیری تقویتی هستند و در واقع این روش در زمینههای مختلفی نظیر پزشکی، تحقیقات عملیاتی، مدیریت منابع طبیعی و غیره نیز مورد استفاده قرار میگیرد. همچنین، ترکیب یادگیری تقویتی با سایر روشهای هوش مصنوعی نظیر یادگیری نظارت شده (Supervised Learning) اجازه میدهد سیستمهای پیچیدهتری را با هوش مصنوعی مدیریت کرد.

اصطلاحات مهم در یادگیری تقویتی

در یادگیری تقویتی، برخی اصطلاحات و مفاهیم کلیدی وجود دارند که درک و آشنایی با آنها میتواند کمک کننده باشد. برخی از اصطلاحات مهم در یادگیری تقویتی به شرح زیر هستند:

- عامل (Agent): عامل، هر سامانهای است که در یک محیط بازی کند و اقداماتی را انجام دهد تا به هدفی خاص برسد. عامل میتواند ربات، نرمافزار، بازیکن مصنوعی و غیره باشد.

- محیط (Environment): محیط، محدوده فیزیکی یا مجازی است که عامل در آن قرار میگیرد و با آن تعامل دارد. محیط میتواند هر چیزی باشد که عامل با آن در تعامل است، مانند جهان واقعی، بازی رایانهای، شبکههای عصبی و غیره.

- حالت (State): حالت، وضعیت فعلی محیط را نشان میدهد. این وضعیت ممکن است بر اساس دادههای حسی که عامل دریافت میکند، تعریف شود. حالت میتواند اطلاعاتی مانند موقعیت، سرعت، شرایط محیطی و غیره را شامل شود.

- عمل (Action): عمل، اقدامی است که عامل انجام میدهد تا وضعیت محیط را تغییر دهد. عمل میتواند یک گزینه مشخص از مجموعه عملهای ممکن یا یک تصمیم گیری پیچیده باشد.

- پاداش (Reward): پاداش، ارزشی است که به عامل داده میشود بر اساس عملی که انجام داده است. هدف عامل در یادگیری تقویتی، حداکثر کردن پاداشها در طول زمان است. پاداش میتواند مثبت، منفی یا صفر باشد و به عامل اطلاعاتی درباره کیفیت عملکرد خود میدهد.

- سیاست (Policy): سیاست، تابعی است که تعیین میکند که در هر حالت عامل چه عملی را انتخاب کند. سیاست معمولا به صورت استراتژیهای تصمیمگیری مدل میشود که مشخص میکند کدام عمل در هر حالت بهتر است.

- تابع ارزش (Value Function): تابع ارزش، تخمینی است از ارزش یک حالت یا یک جفت حالت و عمل. تابع ارزش نشان میدهد که هر حالت یا جفت حالت و عمل چه وضعیتی دارند.

- تابع کیو (Q-Function): تابع Q، تابعی است که برای هر جفت حالت و عمل، ارزش مورد انتظار (مجموعه پاداشهای آتی) را تخمین میزند. تابع Q به صورت مستقیم از سیاست و تابع پاداش استفاده میکند.

- تابع هدف (Objective Function): تابع هدف، معیاری است که برای اندازهگیری عملکرد عامل در یادگیری تقویتی استفاده میشود. هدف ممکن است حداکثر کردن پاداش کلی، حداقل کردن جریمه یا دستیابی به یک هدف خاص باشد.

- تابع انتقال (Transition Function): تابع انتقال، تابعی است که وضعیت بعدی محیط را بر اساس وضعیت فعلی و عمل انجام شده توسط عامل محاسبه میکند.

- خط مشی (Policy Gradient): خط مشی، روشی است که از گرادیان تابع هدف برای بهبود سیاست استفاده میکند. در این روش، گرادیان سیاست نسبت به پارامترهای سیاست محاسبه میشود و بر اساس آنها سیاست بهبود می یابد.

- عامل مبتنی بر مدل (Model-Based Agent): عامل مبتنی بر مدل، عاملی است که یک مدل دقیق از محیط را دارد و از آن برای برنامهریزی و برنامهنویسی عملکرد خود استفاده میکند. این مدل به عامل اجازه میدهد وضعیتهای آتی را پیش بینی کند و برنامهریزی بهینهتری را انجام دهد.

- استراتژی اکتشاف و بهرهبرداری (Exploration and Exploitation Strategy): استراتژی اکتشاف و بهرهبرداری، تعادلی است که عامل باید بین کاوش محیط برای کشف عملکردهای بهتر و بهرهبرداری از عملکردهای قبلی برای بهبود کارایی خود برقرار کند.

- شبکه عصبی عمیق (Deep Neural Network): شبکه عصبی عمیق، یک معماری شبکه عصبی است که شامل لایههای ژرف و پیچیدهتری است. این شبکهها معمولا برای تقویت یادگیری استفاده میشوند، زیرا قابلیت یادگیری و تعمیم بالایی دارند.

بدون دیدگاه